Sebuah teknik baru dapat menempatkan model AI pada diet energi yang ketat, berpotensi memangkas konsumsi daya hingga 95% tanpa mengurangi kualitas.

Para peneliti di BitEnergy AI, Inc. telah mengembangkan Perkalian Kompleksitas Linier (L-Mul), sebuah metode yang menggantikan perkalian floating-point yang membutuhkan banyak energi dengan penjumlahan integer yang lebih sederhana dalam perhitungan AI.

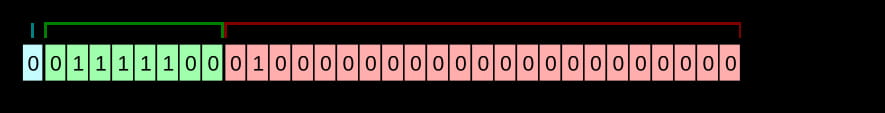

Bagi mereka yang tidak terbiasa dengan istilah tersebut, floating-point adalah singkatan matematika yang memungkinkan komputer menangani angka yang sangat besar dan sangat kecil secara efisien dengan menyesuaikan penempatan titik desimal. Anda dapat menganggapnya seperti notasi ilmiah, dalam biner. Mereka penting untuk banyak perhitungan dalam model AI, tetapi mereka membutuhkan banyak energi dan daya komputasi. Semakin besar angkanya, semakin baik modelnya—dan semakin banyak daya komputasi yang dibutuhkannya. Fp32 umumnya merupakan model presisi penuh, dengan pengembang mengurangi presisi menjadi fp16, fp8, dan bahkan fp4, sehingga model mereka dapat berjalan pada perangkat keras lokal.

Gambar: Wikipedia

Hasrat AI yang besar terhadap listrik telah menjadi perhatian yang terus berkembang. ChatGPT sendiri menghabiskan 564 MWh setiap hari—cukup untuk memberi daya pada 18.000 rumah di Amerika. Industri AI secara keseluruhan diperkirakan akan menghabiskan 85-134 TWh setiap tahunnya pada tahun 2027, kira-kira sama dengan operasi penambangan Bitcoin, menurut estimasi yang dibagikan oleh Cambridge Centre for Alternative Finance.

L-Mul mengatasi masalah energi AI secara langsung dengan menata ulang cara model AI menangani kalkulasi. Alih-alih perkalian floating-point yang rumit, L-Mul memperkirakan operasi ini menggunakan penjumlahan integer. Jadi, misalnya, alih-alih mengalikan 123,45 dengan 67,89, L-Mul memecahnya menjadi langkah-langkah yang lebih kecil dan lebih mudah menggunakan penjumlahan. Hal ini membuat kalkulasi lebih cepat dan menggunakan lebih sedikit energi, sambil tetap mempertahankan akurasi.

Hasilnya tampak menjanjikan. "Menerapkan operasi L-Mul dalam perangkat keras pemrosesan tensor berpotensi mengurangi biaya energi hingga 95% melalui perkalian tensor floating point per elemen dan biaya energi hingga 80% untuk produk titik," klaim para peneliti. Tanpa membuatnya terlalu rumit, artinya adalah ini: Jika sebuah model menggunakan teknik ini, dibutuhkan energi 95% lebih sedikit untuk berpikir, dan energi 80% lebih sedikit untuk memunculkan ide-ide baru, menurut penelitian ini.

Dampak algoritme ini melampaui penghematan energi. L-Mul mengungguli standar 8-bit saat ini dalam beberapa kasus, mencapai presisi yang lebih tinggi sambil menggunakan komputasi tingkat bit yang jauh lebih sedikit. Pengujian di seluruh pemrosesan bahasa alami, tugas penglihatan, dan penalaran simbolik menunjukkan penurunan kinerja rata-rata hanya 0,07%—pengorbanan yang dapat diabaikan untuk potensi penghematan energi.

Model berbasis transformer, tulang punggung model bahasa besar seperti GPT, dapat memperoleh manfaat besar dari L-Mul. Algoritmenya terintegrasi dengan lancar ke dalam mekanisme perhatian, bagian intensif komputasi dari model ini. Pengujian pada model populer seperti Llama, Mistral, dan Gemma bahkan mengungkap beberapa peningkatan akurasi pada tugas penglihatan tertentu.

Gambar: Bitenergy.ai melalui ArXiv

Pada tingkat operasional, keunggulan L-Mul menjadi lebih jelas. Penelitian menunjukkan bahwa perkalian dua angka float8 (cara model AI beroperasi saat ini) memerlukan 325 operasi, sementara L-Mul hanya menggunakan 157—kurang dari setengahnya. “Untuk meringkas analisis kesalahan dan kompleksitas, L-Mul lebih efisien dan lebih akurat daripada perkalian fp8,” simpul penelitian tersebut.

Namun, tidak ada yang sempurna dan teknik ini mempunyai kelemahan besar: Ia memerlukan jenis perangkat keras khusus, sehingga perangkat keras yang ada saat ini belum dioptimalkan untuk memanfaatkannya secara maksimal.

Rencana untuk perangkat keras khusus yang secara native mendukung kalkulasi L-Mul mungkin sudah berjalan. "Untuk membuka potensi penuh dari metode yang kami usulkan, kami akan menerapkan algoritma kernel L-Mul dan L-Matmul pada tingkat perangkat keras dan mengembangkan API pemrograman untuk desain model tingkat tinggi," kata para peneliti. Hal ini berpotensi menghasilkan generasi baru model AI yang cepat, akurat, dan sangat murah—yang menjadikan AI hemat energi sebagai kemungkinan yang nyata.