Plus de 2 600 leaders technologiques et chercheurs ont signé une lettre ouverte appelant à une « pause » temporaire dans le développement de l’intelligence artificielle (IA), craignant « des risques profonds pour la société et l’humanité ».

Elon Musk, PDG de Tesla, Steve Wozniak, cofondateur d'Apple, ainsi qu'un grand nombre de PDG, directeurs techniques et chercheurs en IA figuraient parmi les signataires de la lettre, rédigée le 22 mars par le groupe de réflexion américain Future of Life Institute (FOLI).

L’institut a appelé toutes les entreprises d’IA à « suspendre immédiatement » la formation des systèmes d’IA plus puissants que GPT-4 pendant au moins six mois, partageant notamment ses inquiétudes quant au fait que « l’intelligence humaine-compétitive peut présenter de profonds risques pour la société et l’humanité ». :

« L’IA avancée pourrait représenter un changement profond dans l’histoire de la vie sur Terre et devrait être planifiée et gérée avec des soins et des ressources proportionnés. Malheureusement, ce niveau de planification et de gestion n’est pas atteint », écrit l’institut dans sa lettre.

GPT-4 est la dernière itération du chatbot basé sur l'intelligence artificielle d'OpenAI, lancé le 14 mars. À ce jour, il a réussi certains des examens de lycée et de droit les plus rigoureux des États-Unis dans le 90e centile. Il est censé être 10 fois plus avancé que la version originale de ChatGPT.

Il existe une « course incontrôlable » entre les sociétés d’IA pour développer une IA plus puissante, que « personne – pas même leurs créateurs – ne peut comprendre, prédire ou contrôler de manière fiable », a affirmé FOLI.

L’une des principales préoccupations était de savoir si les machines pourraient inonder les canaux d’information, potentiellement de « propagande et de mensonges », et si les machines « automatiseraient » toutes les opportunités d’emploi.

FOLI a poussé ces préoccupations encore plus loin, suggérant que les efforts entrepreneuriaux de ces sociétés d’IA pourraient conduire à une menace existentielle :

« Devrions-nous développer des esprits non humains qui pourraient éventuellement être plus nombreux, plus intelligents, obsolètes et nous remplacer ? Devons-nous risquer de perdre le contrôle de notre civilisation ?

"De telles décisions ne doivent pas être déléguées à des dirigeants technologiques non élus", ajoute la lettre.

L'institut est également d'accord avec une récente déclaration du fondateur d'OpenAI, Sam Altman, suggérant qu'un examen indépendant pourrait être nécessaire avant de former les futurs systèmes d'IA.

Altman, dans son article de blog du 24 février, a souligné la nécessité de se préparer aux robots d'intelligence générale artificielle (AGI) et de superintelligence artificielle (ASI).

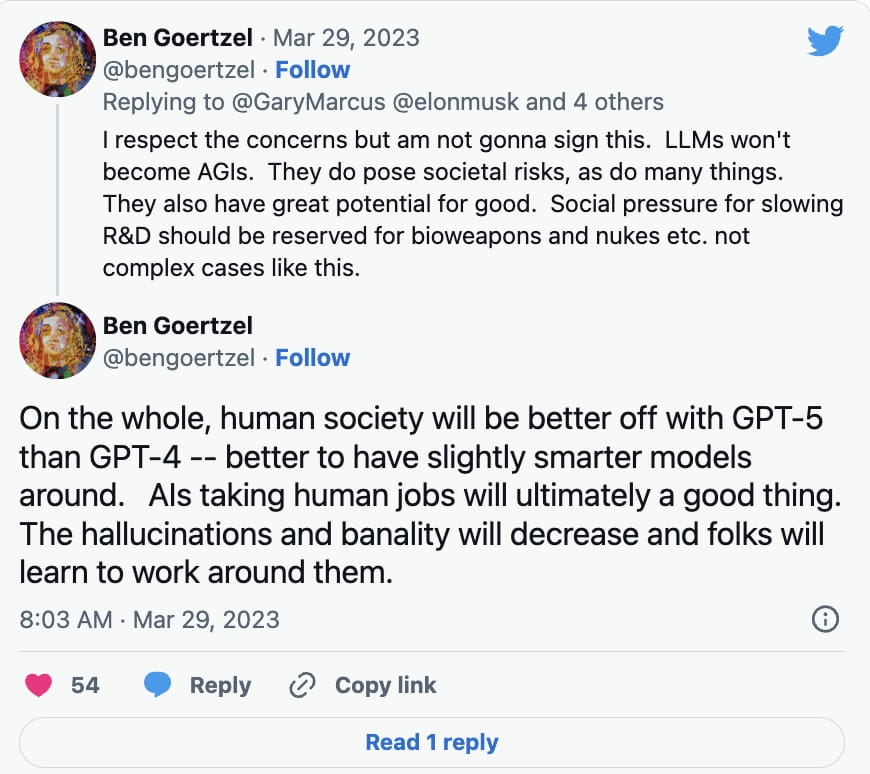

Cependant, tous les experts de l’IA ne se sont pas précipités pour signer la pétition. Ben Goertzel, PDG de SingularityNET, a expliqué dans une réponse Twitter du 29 mars à Gary Marcus, l'auteur de Rebooting.AI, que les modèles d'apprentissage des langues (LLM) ne deviendront pas des AGI, pour lesquelles, à ce jour, il y a eu peu de développements.

Au lieu de cela, il a déclaré que la recherche et le développement devraient être ralentis pour des choses comme les armes biologiques et nucléaires :

En plus des modèles d’apprentissage des langues comme ChatGPT, la technologie de contrefaçon profonde basée sur l’IA a été utilisée pour créer des images convaincantes, des canulars audio et vidéo. La technologie a également été utilisée pour créer des œuvres d’art générées par l’IA, avec certaines inquiétudes quant à savoir si elle pourrait violer les lois sur le droit d’auteur dans certains cas.

Le PDG de Galaxy Digital, Mike Novogratz, a récemment déclaré aux investisseurs qu'il était choqué par l'attention réglementaire accordée à la cryptographie, alors que peu d'attention était portée à l'intelligence artificielle.

« Quand je pense à l’IA, cela me choque que nous parlions autant de réglementation de la cryptographie et rien de la réglementation de l’IA. Je veux dire, je pense que le gouvernement a complètement sens dessus dessous », a-t-il déclaré lors d’une conférence téléphonique avec les actionnaires le 28 mars.

FOLI a fait valoir que si une pause dans le développement de l’IA n’était pas adoptée rapidement, les gouvernements devraient s’impliquer dans un moratoire.

« Cette pause doit être publique et vérifiable, et inclure tous les acteurs clés. Si une telle pause ne peut être adoptée rapidement, les gouvernements devraient intervenir et instaurer un moratoire », écrit-il.