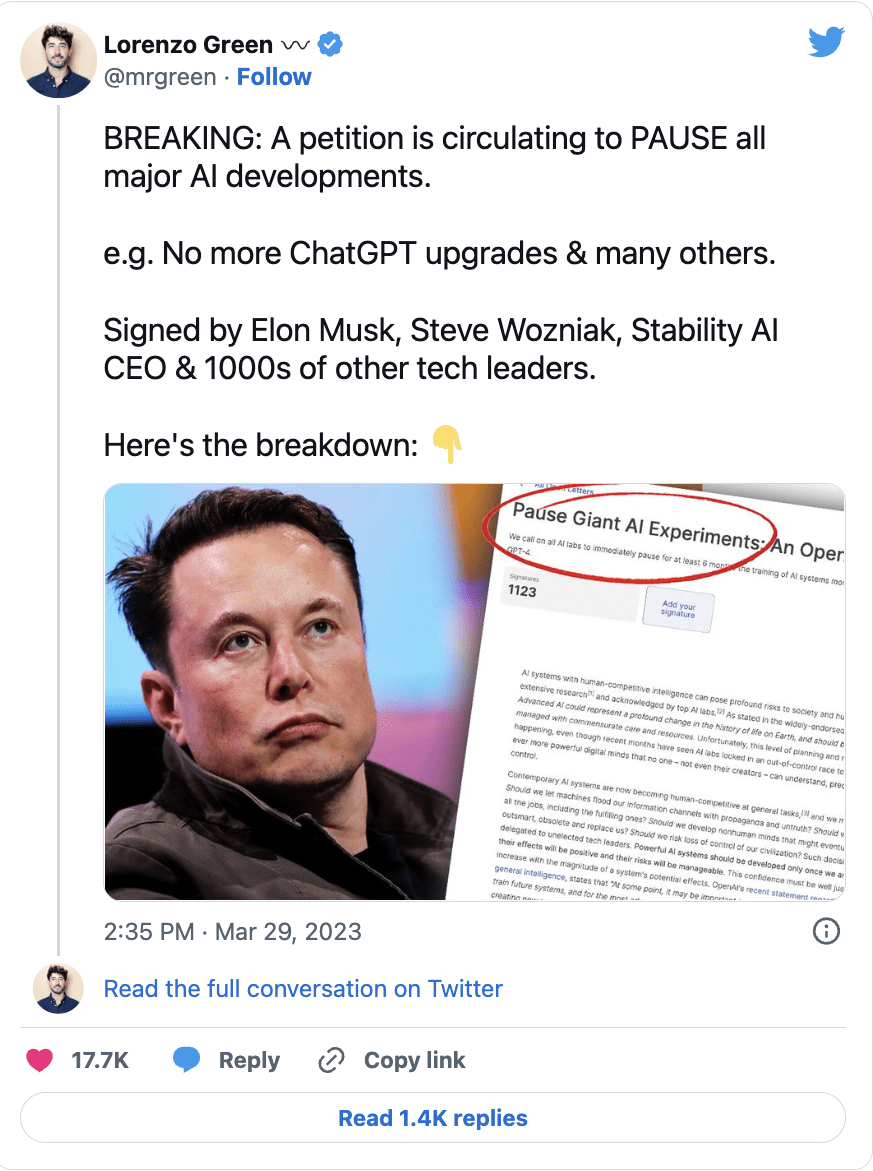

Peste 2.600 de lideri tehnologici și cercetători au semnat o scrisoare deschisă prin care îndeamnă la o „pauză” temporară în dezvoltarea ulterioară a inteligenței artificiale (AI), temându-se de „riscuri profunde pentru societate și umanitate”.

CEO-ul Tesla, Elon Musk, co-fondatorul Apple, Steve Wozniak, și o mulțime de directori generali, directori tehnici și cercetători AI s-au numărat printre semnatarii scrisorii, care a fost scrisă de think tank-ul american Future of Life Institute (FOLI) pe 22 martie.

Institutul a cerut tuturor companiilor de inteligență artificială să „oprească imediat” instruirea sistemelor de inteligență artificială care sunt mai puternice decât GPT-4 timp de cel puțin șase luni, împărtășind îngrijorarea că „inteligența umană-competitivă poate prezenta riscuri profunde pentru societate și umanitate”, printre altele. :

„AI avansate ar putea reprezenta o schimbare profundă în istoria vieții pe Pământ și ar trebui să fie planificată și gestionată cu grijă și resurse pe măsură. Din păcate, acest nivel de planificare și management nu are loc”, a scris institutul în scrisoarea sa.

GPT-4 este cea mai recentă versiune a chatbot-ului OpenAI alimentat de inteligență artificială, care a fost lansat pe 14 martie. Până în prezent, a promovat unele dintre cele mai riguroase examene de liceu și drept din SUA în cadrul percentilei 90. Se înțelege că este de 10 ori mai avansat decât versiunea originală a ChatGPT.

Există o „cursă scăpată de control” între firmele AI pentru a dezvolta AI mai puternică, pe care „nimeni – nici măcar creatorii lor – nu o poate înțelege, prezice sau controla în mod fiabil”, a susținut FOLI.

Printre preocupările principale au fost dacă mașinile ar putea inunda canalele de informare, potențial cu „propaganda și neadevăr” și dacă mașinile vor „automatiza” toate oportunitățile de angajare.

FOLI a dus aceste preocupări cu un pas mai departe, sugerând că eforturile antreprenoriale ale acestor companii de inteligență artificială pot duce la o amenințare existențială:

„Ar trebui să dezvoltăm minți non-umane care, în cele din urmă, ar putea să ne depășească numeric, să ne depășească și să ne înlocuiască? Ar trebui să riscăm să pierdem controlul asupra civilizației noastre?”

„Astfel de decizii nu trebuie să fie delegate unor lideri nealeși din domeniul tehnologiei”, se adaugă scrisoarea.

Institutul a fost, de asemenea, de acord cu o declarație recentă a fondatorului OpenAI, Sam Altman, care sugerează că ar putea fi necesară o revizuire independentă înainte de a antrena viitoarele sisteme AI.

Altman, în postarea sa pe blog din 24 februarie, a evidențiat necesitatea de a se pregăti pentru roboții de inteligență generală artificială (AGI) și superinteligență artificială (ASI).

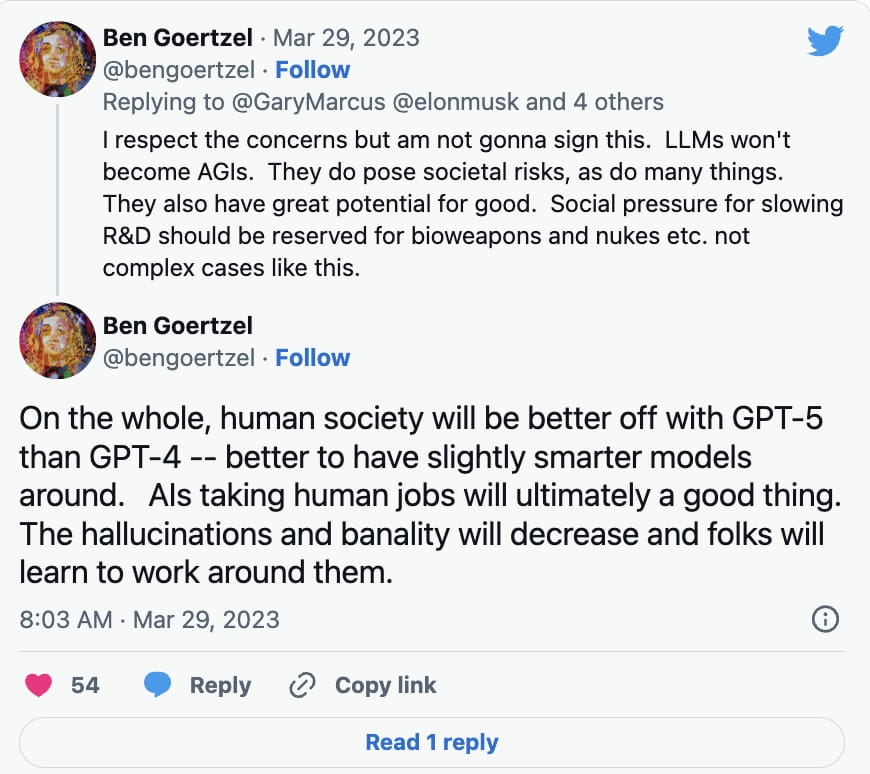

Totuși, nu toți expertii AI s-au grăbit să semneze petiția. Ben Goertzel, CEO-ul SingularityNET, a explicat într-un răspuns pe Twitter din 29 martie lui Gary Marcus, autorul cărții Rebooting.AI, că modelele de învățare a limbilor (LLM) nu vor deveni AGI, care, până în prezent, au existat puține dezvoltări.

În schimb, el a spus că cercetarea și dezvoltarea ar trebui încetinite pentru lucruri precum armele biologice și armele nucleare:

Pe lângă modelele de învățare a limbilor străine precum ChatGPT, tehnologia deep fake alimentată de AI a fost folosită pentru a crea imagini convingătoare, farse audio și video. Tehnologia a fost, de asemenea, folosită pentru a crea lucrări de artă generate de inteligență artificială, s-au ridicat unele îngrijorări cu privire la faptul că ar putea încălca legile drepturilor de autor în anumite cazuri.

CEO-ul Galaxy Digital, Mike Novogratz, le-a spus recent investitorilor că a fost șocat de cantitatea de atenție acordată de reglementare cripto, în timp ce puțin s-a acordat inteligenței artificiale.

„Când mă gândesc la AI, mă șochează că vorbim atât de mult despre reglementarea criptografică și nimic despre reglementarea AI. Adică, cred că guvernul a pus totul pe dos”, a opinat el în timpul unei apeluri a acționarilor din 28 martie.

FOLI a susținut că, în cazul în care o pauză de dezvoltare a AI nu va fi adoptată rapid, guvernele ar trebui să se implice cu un moratoriu.

„Această pauză ar trebui să fie publică și verificabilă și să includă toți actorii cheie. Dacă o astfel de pauză nu poate fi adoptată rapid, guvernele ar trebui să intervină și să instituie un moratoriu”, a scris acesta.