Mais de 2.600 líderes tecnológicos e investigadores assinaram uma carta aberta apelando a uma “pausa” temporária no desenvolvimento da inteligência artificial (IA), temendo “riscos profundos para a sociedade e a humanidade”.

O CEO da Tesla, Elon Musk, o cofundador da Apple, Steve Wozniak, e uma série de CEOs, CTOs e pesquisadores de IA estavam entre os signatários da carta, de autoria do think tank dos Estados Unidos Future of Life Institute (FOLI) em 22 de março.

O instituto apelou a todas as empresas de IA para “pausarem imediatamente” o treino de sistemas de IA que sejam mais poderosos que o GPT-4 durante pelo menos seis meses, partilhando preocupações de que “a inteligência humano-competitiva pode representar riscos profundos para a sociedade e a humanidade”, entre outras coisas. :

“A IA avançada pode representar uma mudança profunda na história da vida na Terra e deve ser planeada e gerida com cuidado e recursos proporcionais. Infelizmente, este nível de planeamento e gestão não está a acontecer”, escreveu o instituto na sua carta.

GPT-4 é a mais recente iteração do chatbot baseado em inteligência artificial da OpenAI, lançado em 14 de março. Até o momento, ele foi aprovado em alguns dos mais rigorosos exames de ensino médio e de direito dos EUA, dentro do percentil 90. É considerado 10 vezes mais avançado que a versão original do ChatGPT.

Há uma “corrida descontrolada” entre empresas de IA para desenvolver uma IA mais poderosa, que “ninguém – nem mesmo os seus criadores – pode compreender, prever ou controlar de forma confiável”, afirmou a FOLI.

Entre as principais preocupações estava se as máquinas poderiam inundar os canais de informação, potencialmente com “propaganda e mentira” e se as máquinas iriam “automatizar” todas as oportunidades de emprego.

A FOLI levou estas preocupações um passo adiante, sugerindo que os esforços empresariais destas empresas de IA podem levar a uma ameaça existencial:

“Devemos desenvolver mentes não-humanas que possam eventualmente superar-nos em número, ser mais espertas, obsoletas e substituir-nos? Deveríamos correr o risco de perder o controle da nossa civilização?”

“Tais decisões não devem ser delegadas a líderes tecnológicos não eleitos”, acrescenta a carta.

O instituto também concordou com uma declaração recente do fundador da OpenAI, Sam Altman, sugerindo que uma revisão independente pode ser necessária antes de treinar futuros sistemas de IA.

Altman, em sua postagem no blog de 24 de fevereiro, destacou a necessidade de se preparar para robôs de inteligência artificial geral (AGI) e superinteligência artificial (ASI).

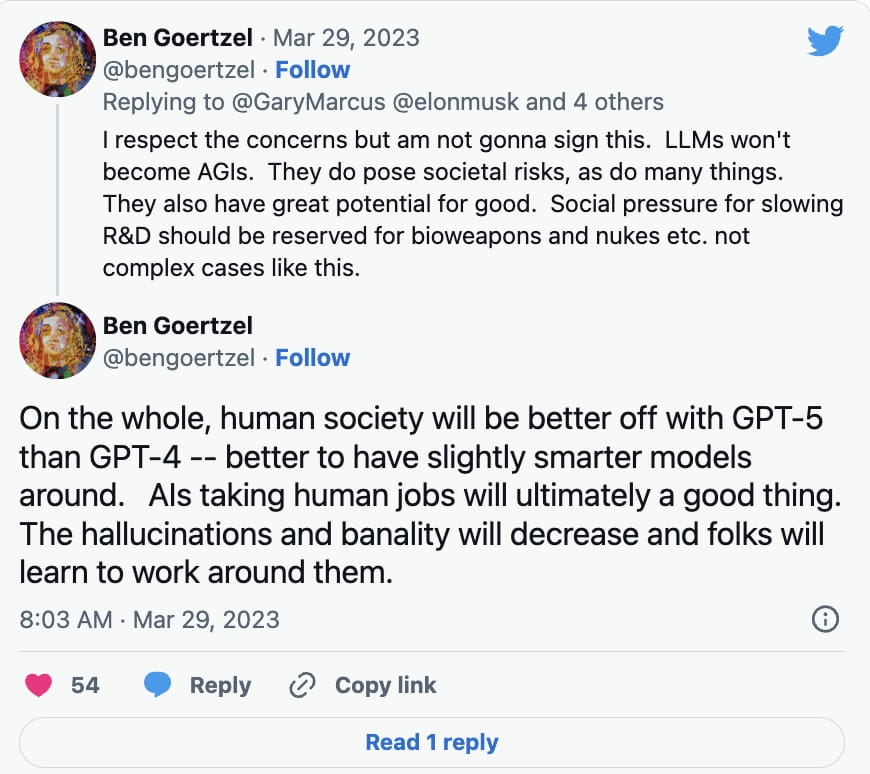

Nem todos os especialistas em IA se apressaram em assinar a petição. Ben Goertzel, CEO da SingularityNET, explicou em uma resposta no Twitter de 29 de março a Gary Marcus, autor de Rebooting.AI, que os modelos de aprendizagem de línguas (LLMs) não se tornarão AGIs, dos quais, até o momento, houve poucos desenvolvimentos.

Em vez disso, ele disse que a pesquisa e o desenvolvimento deveriam ser desacelerados para coisas como armas biológicas e armas nucleares:

Além de modelos de aprendizagem de idiomas como o ChatGPT, a tecnologia deep fake alimentada por IA tem sido usada para criar imagens convincentes, boatos de áudio e vídeo. A tecnologia também tem sido usada para criar obras de arte geradas por IA, com algumas preocupações levantadas sobre se ela poderia violar as leis de direitos autorais em certos casos.

O CEO da Galaxy Digital, Mike Novogratz, disse recentemente aos investidores que ficou chocado com a quantidade de atenção regulatória dada à criptografia, enquanto pouca atenção foi dada à inteligência artificial.

“Quando penso em IA, fico chocado que estejamos falando tanto sobre regulamentação de criptografia e nada sobre regulamentação de IA. Quer dizer, acho que o governo está completamente de cabeça para baixo”, opinou ele durante uma teleconferência com acionistas em 28 de março.

A FOLI argumentou que, caso a pausa no desenvolvimento da IA não seja promulgada rapidamente, os governos deveriam envolver-se com uma moratória.

“Esta pausa deve ser pública e verificável e incluir todos os principais intervenientes. Se tal pausa não puder ser decretada rapidamente, os governos deverão intervir e instituir uma moratória”, escreveu.