Ponad 2600 liderów technologicznych i badaczy podpisało list otwarty, w którym wzywa do tymczasowej „wstrzymania” dalszego rozwoju sztucznej inteligencji (AI), w obawie przed „głębokim zagrożeniem dla społeczeństwa i ludzkości”.

Dyrektor generalny Tesli Elon Musk, współzałożyciel Apple Steve Wozniak oraz wielu dyrektorów generalnych, dyrektorów ds. technologii i badaczy zajmujących się sztuczną inteligencją znaleźli się wśród sygnatariuszy listu, którego autorem był amerykański zespół doradców Future of Life Institute (FOLI) z 22 marca.

Instytut wezwał wszystkie firmy zajmujące się sztuczną inteligencją do „natychmiastowego wstrzymania” szkolenia systemów sztucznej inteligencji, które są potężniejsze niż GPT-4, na co najmniej sześć miesięcy, wyrażając obawy, że „wywiad między ludźmi może stanowić poważne zagrożenie dla społeczeństwa i ludzkości” między innymi :

„Zaawansowana sztuczna inteligencja może oznaczać głęboką zmianę w historii życia na Ziemi i powinna być planowana oraz zarządzana z odpowiednią starannością i zasobami. Niestety, taki poziom planowania i zarządzania nie następuje” – napisał instytut w swoim piśmie.

GPT-4 to najnowsza wersja chatbota OpenAI opartego na sztucznej inteligencji, która została wypuszczona 14 marca. Do tej pory zdał niektóre z najbardziej rygorystycznych amerykańskich egzaminów średnich i prawniczych w 90. percentylu. Uważa się, że jest 10 razy bardziej zaawansowana niż oryginalna wersja ChatGPT.

Istnieje „wymykający się spod kontroli wyścig” pomiędzy firmami zajmującymi się sztuczną inteligencją w celu opracowania potężniejszej sztucznej inteligencji, którego „nikt – nawet ich twórcy – nie jest w stanie zrozumieć, przewidzieć ani niezawodnie kontrolować” – stwierdził FOLI.

Do najważniejszych obaw należało to, czy maszyny mogą zalać kanały informacyjne potencjalnie „propagandą i nieprawdą” oraz czy maszyny „zautomatyzują” wszystkie możliwości zatrudnienia.

FOLI poszło o krok dalej w tych obawach, sugerując, że przedsiębiorcze wysiłki tych firm zajmujących się sztuczną inteligencją mogą prowadzić do egzystencjalnego zagrożenia:

„Czy powinniśmy rozwijać nieludzkie umysły, które w końcu mogą nas przewyższyć liczebnie, przechytrzyć, stać się przestarzałe i zastąpić nas? Czy powinniśmy ryzykować utratę kontroli nad naszą cywilizacją?”

„Takich decyzji nie można delegować niewybranym liderom technologicznym” – dodano w piśmie.

Instytut zgodził się również z niedawnym oświadczeniem założyciela OpenAI Sama Altmana, w którym zasugerowano, że przed szkoleniem przyszłych systemów sztucznej inteligencji może być wymagany niezależny przegląd.

Altman w swoim poście na blogu z 24 lutego podkreślił potrzebę przygotowania się na roboty oparte na sztucznej inteligencji ogólnej (AGI) i sztucznej superinteligencji (ASI).

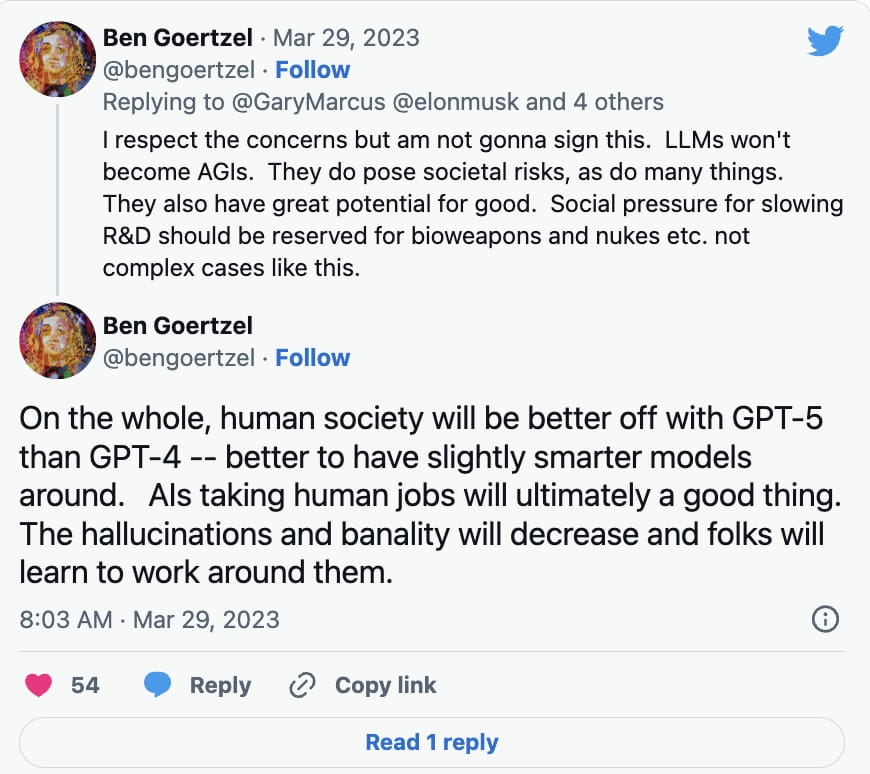

Jednak nie wszyscy eksperci ds. sztucznej inteligencji pośpieszyli z podpisaniem petycji. Ben Goertzel, dyrektor generalny SingularityNET, wyjaśnił w odpowiedzi na Twitterze z 29 marca Gary’emu Marcusowi, autorowi Rebooting.AI, że modele uczenia się języków (LLM) nie staną się AGI, co do tej pory wprowadzono niewiele zmian.

Zamiast tego powiedział, że należy spowolnić badania i rozwój takich rzeczy jak broń biologiczna i nuklearna:

Oprócz modeli nauki języków, takich jak ChatGPT, do tworzenia przekonujących obrazów oraz oszustw audio i wideo wykorzystano technologię deep fake opartą na sztucznej inteligencji. Technologię tę wykorzystano także do tworzenia dzieł sztuki generowanych przez sztuczną inteligencję, przy czym pojawiły się pewne obawy, czy w niektórych przypadkach może ona naruszać prawa autorskie.

Dyrektor generalny Galaxy Digital, Mike Novogratz, powiedział niedawno inwestorom, że jest zszokowany ilością uwagi, jaką organy regulacyjne poświęcono kryptowalutom, podczas gdy niewiele uwagi poświęcono sztucznej inteligencji.

„Kiedy myślę o sztucznej inteligencji, szokuje mnie, że tak dużo mówimy o regulacjach dotyczących kryptowalut, a nic o regulacjach dotyczących sztucznej inteligencji. To znaczy, myślę, że rząd całkowicie wywrócił wszystko do góry nogami” – wyraził swoją opinię podczas rozmowy telefonicznej z akcjonariuszami 28 marca.

FOLI argumentowało, że jeśli wstrzymanie rozwoju sztucznej inteligencji nie zostanie szybko wprowadzone, rządy powinny zaangażować się w wprowadzenie moratorium.

„Ta przerwa powinna być publiczna i możliwa do zweryfikowania oraz obejmować wszystkich kluczowych aktorów. Jeśli takiej pauzy nie da się szybko wprowadzić, rządy powinny wkroczyć i wprowadzić moratorium” – napisano.