Oltre 2.600 leader e ricercatori del settore tecnologico hanno firmato una lettera aperta chiedendo una “pausa” temporanea sullo sviluppo dell’intelligenza artificiale (IA), temendo “profondi rischi per la società e l’umanità”.

Tra i firmatari della lettera, redatta dal think tank statunitense Future of Life Institute (FOLI) il 22 marzo, figurano il CEO di Tesla, Elon Musk, il co-fondatore di Apple Steve Wozniak e una schiera di CEO, CTO e ricercatori nel campo dell'intelligenza artificiale.

L’istituto ha invitato tutte le aziende di intelligenza artificiale a “mettere immediatamente in pausa” per almeno sei mesi l’addestramento dei sistemi di intelligenza artificiale più potenti di GPT-4, condividendo le preoccupazioni sul fatto che “l’intelligenza competitiva umana possa rappresentare rischi profondi per la società e l’umanità”, tra le altre cose:

"L'intelligenza artificiale avanzata potrebbe rappresentare un profondo cambiamento nella storia della vita sulla Terra e dovrebbe essere pianificata e gestita con adeguata cura e risorse. Sfortunatamente, questo livello di pianificazione e gestione non sta avvenendo", ha scritto l'istituto nella sua lettera.

GPT-4 è l'ultima iterazione del chatbot basato sull'intelligenza artificiale di OpenAI, rilasciato il 14 marzo. Ad oggi, ha superato alcuni degli esami di scuola superiore e di giurisprudenza più rigorosi degli Stati Uniti entro il 90° percentile. Si ritiene che sia 10 volte più avanzato della versione originale di ChatGPT.

C'è una "corsa fuori controllo" tra le aziende di intelligenza artificiale per sviluppare un'intelligenza artificiale più potente, che "nessuno - nemmeno i loro creatori - può comprendere, prevedere o controllare in modo affidabile", ha affermato FOLI.

Tra le principali preoccupazioni c’era se le macchine potessero inondare i canali informativi, potenzialmente con “propaganda e falsità” e se le macchine avrebbero “automatizzato” tutte le opportunità di lavoro.

FOLI ha portato queste preoccupazioni un passo oltre, suggerendo che gli sforzi imprenditoriali di queste aziende di intelligenza artificiale potrebbero portare a una minaccia esistenziale:

"Dovremmo sviluppare menti non umane che potrebbero alla fine superarci in numero, essere più furbi, diventare obsoleti e sostituirci? Dovremmo rischiare di perdere il controllo della nostra civiltà?"

"Tali decisioni non devono essere delegate a leader tecnologici non eletti", si legge nella lettera.

L'istituto ha inoltre concordato con una recente dichiarazione del fondatore di OpenAI, Sam Altman, secondo cui potrebbe essere necessaria una revisione indipendente prima di addestrare i futuri sistemi di intelligenza artificiale.

Nel suo post sul blog del 24 febbraio, Altman ha sottolineato la necessità di prepararsi all'arrivo di robot dotati di intelligenza artificiale generale (AGI) e di superintelligenza artificiale (ASI).

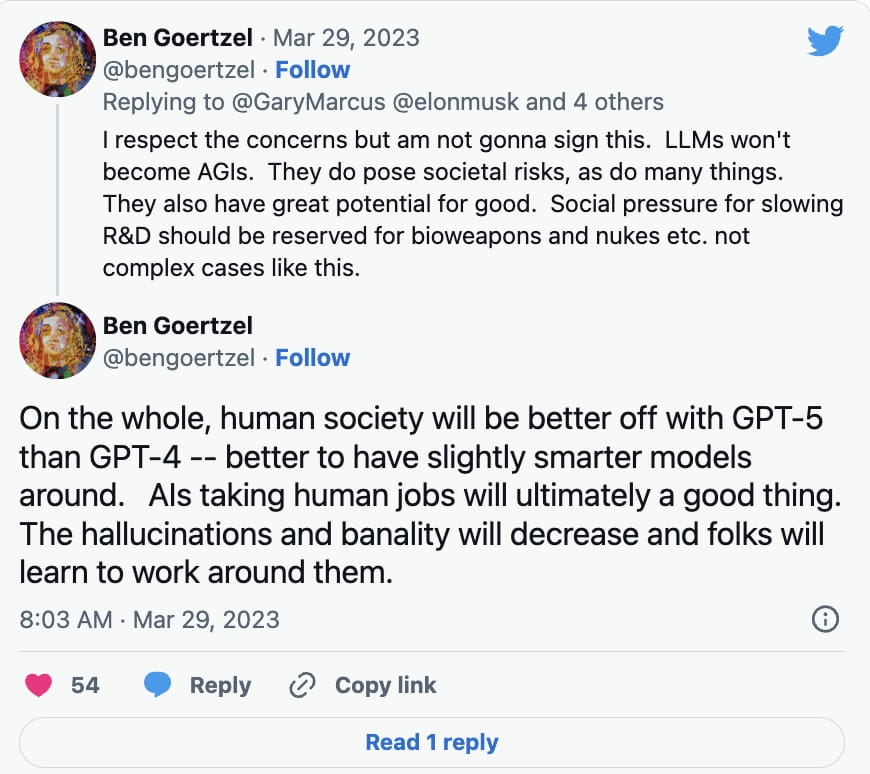

Tuttavia, non tutti gli esperti di IA si sono precipitati a firmare la petizione. Ben Goertzel, CEO di SingularityNET, ha spiegato in una risposta su Twitter del 29 marzo a Gary Marcus, autore di Rebooting.AI, che i modelli di apprendimento linguistico (LLM) non diventeranno AGI, di cui, fino ad oggi, ci sono stati pochi sviluppi.

Ha invece affermato che la ricerca e lo sviluppo dovrebbero essere rallentati per cose come le armi biologiche e quelle nucleari:

Oltre ai modelli di apprendimento linguistico come ChatGPT, la tecnologia deep fake basata sull'intelligenza artificiale è stata utilizzata per creare immagini, audio e video bufale convincenti. La tecnologia è stata utilizzata anche per creare opere d'arte generate dall'intelligenza artificiale, con alcune preoccupazioni sollevate sul fatto che potesse violare le leggi sul copyright in determinati casi.

Mike Novogratz, CEO di Galaxy Digital, ha dichiarato di recente agli investitori di essere rimasto scioccato dalla quantità di attenzione normativa dedicata alle criptovalute, mentre è stata riservata poca attenzione all'intelligenza artificiale.

"Quando penso all'IA, mi sconvolge il fatto che si parli tanto di regolamentazione delle criptovalute e niente di regolamentazione dell'IA. Voglio dire, penso che il governo abbia tutto completamente capovolto", ha affermato durante una chiamata degli azionisti il 28 marzo.

FOLI ha sostenuto che se la sospensione dello sviluppo dell'intelligenza artificiale non dovesse essere attuata rapidamente, i governi dovrebbero intervenire con una moratoria.

"Questa pausa dovrebbe essere pubblica e verificabile, e includere tutti gli attori chiave. Se una tale pausa non può essere attuata rapidamente, i governi dovrebbero intervenire e istituire una moratoria", ha scritto.