Fonte ristampa articolo: AGIing

Questi tre nuovi chip AI di Nvidia non sono "versioni migliorate", ma "versioni ridotte". Tra questi, HGX H20 ha limitazioni in termini di larghezza di banda, velocità di calcolo, ecc. Si prevede che il prezzo di H20 diminuirà, ma lo sarà comunque. inferiore ai chip AI domestici. Il chip 910B è più alto.

Fonte originale: TMTpost Media

Autore: Lin Zhijia

Fonte immagine: generata da Unbounded AI

Il 10 novembre è stato recentemente riferito che il colosso dei chip NVIDIA lancerà tre chip AI per il mercato cinese basati su H100 per far fronte ai più recenti controlli sulle esportazioni di chip negli Stati Uniti.

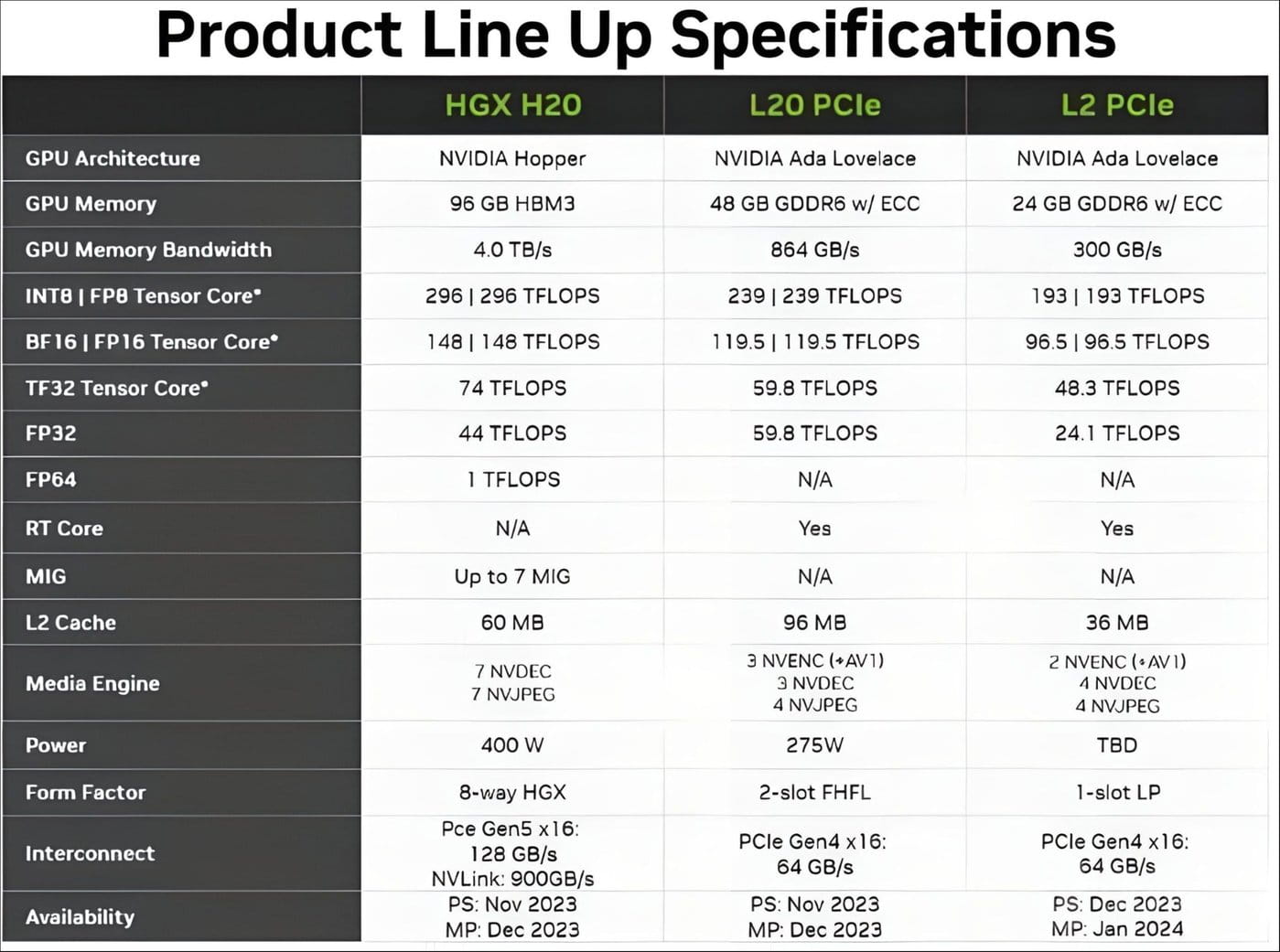

I documenti delle specifiche mostrano che Nvidia lancerà presto nuovi prodotti denominati HGX H20, L20 PCle e L2 PCle per i clienti cinesi, basati sull'architettura Hopper e Ada Lovelace di Nvidia. A giudicare dalle specifiche e dalla denominazione, i tre prodotti sono mirati a scenari di formazione, inferenza e edge. Verranno annunciati già il 16 novembre. Il periodo di campionamento del prodotto sarà da novembre a dicembre di quest'anno, e il tempo di produzione di massa sarà. da dicembre a gennaio dell'anno prossimo.

L'app TMTpost ha appreso da molte aziende della catena industriale NVIDIA che la notizia di cui sopra è vera.

TMTpost Media App ha inoltre appreso in esclusiva che i tre chip AI di Nvidia non sono "versioni migliorate" ma "versioni ridotte". Tra questi, l'HGX H20 utilizzato per l'addestramento del modello AI presenta limitazioni in termini di larghezza di banda, velocità di calcolo, ecc. Teoricamente, la potenza di calcolo complessiva è inferiore di circa l'80% rispetto a quella del chip GPU NVIDIA H100, ovvero l'H20 è pari a 20 % delle prestazioni di potenza di calcolo complessive dell'H100 e aggiungi memoria HBM e moduli di interconnessione NVLink per aumentare i costi della potenza di calcolo. Pertanto, anche se il prezzo dell'HGX H20 diminuirà rispetto all'H100, si prevede che il prezzo di questo prodotto sarà comunque superiore a quello del chip AI domestico 910B.

"Ciò equivale ad allargare le corsie autostradali, ma non viene allargato l'ingresso del casello, limitando il flusso. Anche tecnicamente, attraverso blocchi hardware e software, le prestazioni del chip possono essere controllate con precisione, senza sostituzione su larga scala delle linee di produzione Anche se l'hardware viene aggiornato, le prestazioni restano invariate Tuttavia, può essere regolato secondo necessità. Al momento, le prestazioni del nuovo H20 sono state "bloccate" dalla fonte "Un esperto del settore ha spiegato il nuovo chip H20, "Ad esempio, ci volevano 20 giorni per eseguire un compito con l’H100, ma ora con l’H20 no. La corsa potrebbe richiedere 100 giorni.”

Sebbene gli Stati Uniti abbiano emesso una nuova serie di restrizioni sui chip, Nvidia non sembra rinunciare all'enorme mercato cinese della potenza di calcolo dell'intelligenza artificiale.

Quindi, i chip domestici possono essere sostituiti? L'app TMTpost Media ha appreso che dopo i test, l'attuale chip AI domestico 910B può raggiungere solo circa il 60%-70% di A100 in termini di inferenza di modelli di grandi dimensioni, rendendo allo stesso tempo insostenibile l'addestramento del modello di cluster, 910B ha problemi in termini di consumo di energia di calcolo e generazione di calore. È molto più elevato rispetto ai prodotti della serie NVIDIA A100/H100 sotto altri aspetti e non è compatibile con CUDA, rendendo difficile soddisfare pienamente le esigenze di formazione dei modelli dei centri di calcolo intelligenti a lungo termine.

Al momento, i funzionari di Nvidia non hanno rilasciato alcun commento al riguardo.

È stato riferito che il 17 ottobre di quest'anno, il Bureau of Industry and Security (BIS) del Dipartimento del Commercio degli Stati Uniti ha emesso nuove norme sul controllo delle esportazioni di chip, imponendo nuovi controlli sulle esportazioni di prodotti a semiconduttori, inclusi i chip AI ad alte prestazioni di Nvidia entrato in vigore il 23 ottobre. I documenti depositati da NVIDIA presso la SEC statunitense mostrano che i prodotti vietati che entrano in vigore immediatamente includono i chip AI più potenti, A800, H800 e L40S.

Inoltre, i processori di chip L40 e RTX 4090 mantengono il periodo di finestra originale di 30 giorni.

Il 31 ottobre è arrivata la notizia che Nvidia potrebbe essere costretta a cancellare ordini per chip avanzati del valore di 5 miliardi di dollari. Colpito dalla notizia, il prezzo delle azioni di Nvidia è crollato bruscamente. In precedenza, i prodotti NVIDIA A800 e H800, forniti esclusivamente in Cina, non potevano essere venduti sul mercato cinese a causa delle nuove normative statunitensi. Questi due chip erano chiamati "versioni castrate" di A100 e H100. NVIDIA ha abbassato il prezzo per conformarsi con le precedenti normative statunitensi migliorano le prestazioni del chip.

Il 31 ottobre, Zhang Xin, portavoce del Consiglio cinese per la promozione del commercio internazionale, ha dichiarato che le nuove norme sul controllo delle esportazioni di semiconduttori emanate dagli Stati Uniti verso la Cina hanno ulteriormente inasprito le restrizioni sull'esportazione di chip legati all'intelligenza artificiale e sulla produzione di semiconduttori. attrezzature in Cina e ha elencato una serie di entità cinesi come "lista di entità" per il controllo delle importazioni e delle esportazioni. Queste misure statunitensi violano gravemente i principi dell’economia di mercato e le regole economiche e commerciali internazionali, esacerbando il rischio di lacerazione e frammentazione della catena di fornitura globale dei semiconduttori. Il divieto sulle esportazioni di chip verso la Cina, attuato dagli Stati Uniti a partire dalla seconda metà del 2022, sta cambiando profondamente la domanda e l'offerta globale, causando uno squilibrio nell'offerta di chip nel 2023, influenzando il modello dell'industria mondiale dei chip e danneggiando gli interessi delle aziende provenienti da tutto il mondo. vari paesi, comprese le aziende cinesi.

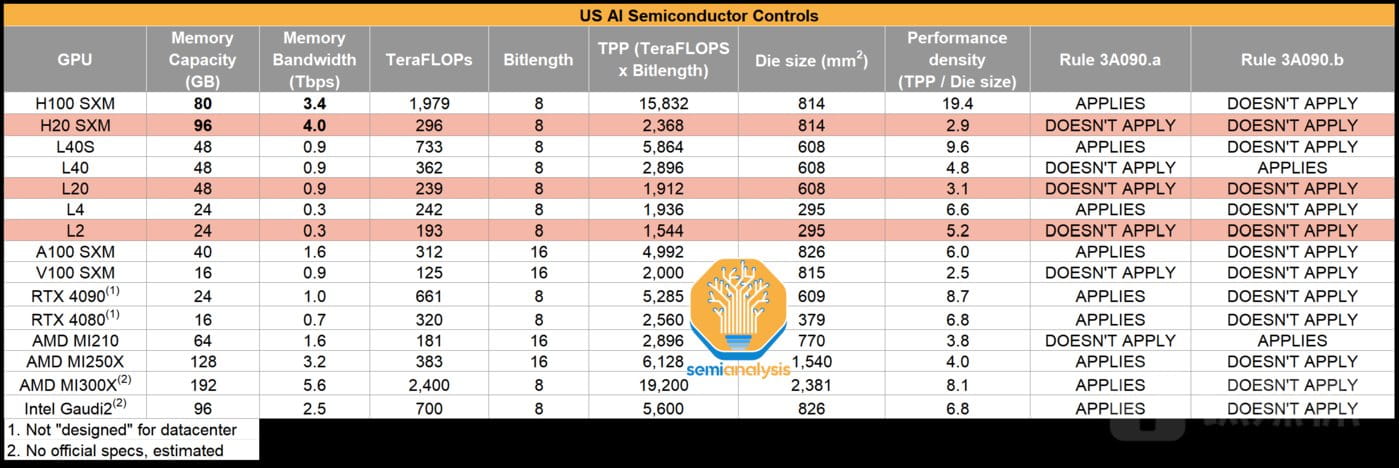

Confronto dei parametri prestazionali tra NVIDIA HGX H20, L20, L2 e altri prodotti

TMTpost Media App ha appreso che i nuovi prodotti chip AI HGX H20, L20 e L2 si basano rispettivamente sulle architetture Hopper e Ada di NVIDIA e sono adatti per il cloud training, il cloud ragionamento e il ragionamento edge.

Tra questi, i prodotti di inferenza AI degli ultimi due L20 e L2 hanno soluzioni simili di "sostituzione domestica" e compatibili con CUDA, mentre HGX H20 è un prodotto chip di addestramento AI basato su H100 e tramite castrazione del firmware. Sostituisce principalmente A100/. H800 In Cina, oltre a NVIDIA, ci sono poche soluzioni domestiche simili nella formazione dei modelli.

I documenti mostrano che il nuovo H20 dispone della tecnologia di packaging avanzata CoWoS e aggiunge una HBM3 (memoria ad alte prestazioni) a 96 GB, ma anche il costo aumenta di 240 dollari S (Trilioni di operazioni in virgola mobile al secondo) rappresentano circa il 15% della potenza di calcolo dell'H100, quindi sono necessari algoritmi aggiuntivi e costi di personale; NVLink viene aggiornato da 400 GB/s a 900 GB/s, quindi la velocità di interconnessione sarà più elevata aggiornamento.

Secondo la valutazione, H100/H800 è l'attuale soluzione pratica tradizionale per i cluster di potenza di calcolo. Tra questi, il limite teorico di H100 è un cluster di 50.000 carte, con una potenza di calcolo massima di 100.000 P; il cluster pratico massimo di H800 è di 20.000-30.000 carte, con una potenza di calcolo massima di 40.000 P; A100 è di 16.000 carte, la potenza di calcolo massima è 9600P.

Tuttavia, il nuovo chip H20 di oggi ha un limite teorico di 50.000 cluster di carte, ma ciascuna carta ha una potenza di calcolo di 0,148P, per un totale di quasi 7400P di potenza di calcolo, che è inferiore a H100/H800 e A100. Pertanto, la scala del cluster H20 è molto inferiore alla scala teorica di H100. Sulla base della stima della potenza di calcolo e dell'equilibrio delle comunicazioni, la potenza di calcolo media complessiva ragionevole è di circa 3000P. È necessario aggiungere più costi e più potenza di calcolo per completare il progetto compito. Formazione del modello con miliardi di parametri.

Due esperti del settore dei semiconduttori hanno dichiarato all'app TMTpost che, in base alle attuali stime dei parametri di prestazione, è molto probabile che i prodotti GPU Nvidia B100 non saranno più venduti sul mercato cinese l'anno prossimo.

Nel complesso, se una grande azienda di modelli vuole condurre un addestramento di grandi modelli con parametri come GPT-4, la scala del cluster informatico è il nucleo. Attualmente, solo H800 e H100 sono in grado di eseguire l'addestramento di grandi modelli, mentre le prestazioni sono domestiche 910B è tra A100 e H100 Nel mezzo, è solo una "opzione di ultima istanza".

Al giorno d'oggi, il nuovo H20 lanciato da NVIDIA è più adatto per l'addestramento e il ragionamento dei modelli verticali. Non può soddisfare le esigenze di formazione di modelli di grandi dimensioni a livello di trilioni, tuttavia, le prestazioni complessive sono leggermente superiori a 910B. Insieme all'ecosistema CUDA di NVIDIA, blocca Restrizioni sui chip negli Stati Uniti Secondo l’ordinanza, in futuro le carte nazionali avranno l’unica scelta nel mercato cinese dei chip AI.

L’ultimo rapporto finanziario mostra che nel trimestre terminato il 30 luglio, oltre l’85% delle vendite di Nvidia, pari a 13,5 miliardi di dollari, provenivano da Stati Uniti e Cina, e solo circa il 14% delle vendite proveniva da altri paesi e regioni.

Influenzato dalle notizie del semestre 2020, alla chiusura del mercato azionario statunitense il 9 novembre, il prezzo delle azioni NVIDIA è aumentato leggermente dello 0,81% per chiudere a 469,5 dollari per azione. Negli ultimi cinque giorni di negoziazione, Nvidia è cresciuta di oltre il 10%, con il suo ultimo valore di mercato che ha raggiunto 1,16 trilioni di dollari.