Más de 2.600 líderes e investigadores tecnológicos firmaron una carta abierta instando a una “pausa” temporal en el desarrollo de la inteligencia artificial (IA), por temor a “profundos riesgos para la sociedad y la humanidad”.

El director ejecutivo de Tesla, Elon Musk, el cofundador de Apple, Steve Wozniak, y una serie de directores ejecutivos, directores de tecnología e investigadores de inteligencia artificial se encontraban entre los firmantes de la carta, escrita por el grupo de expertos estadounidense Future of Life Institute (FOLI) el 22 de marzo.

El instituto pidió a todas las empresas de IA que "pausen inmediatamente" el entrenamiento de sistemas de IA que sean más potentes que GPT-4 durante al menos seis meses, compartiendo la preocupación de que "la inteligencia humana competitiva pueda plantear riesgos profundos para la sociedad y la humanidad", entre otras cosas. :

“La IA avanzada podría representar un cambio profundo en la historia de la vida en la Tierra y debería planificarse y gestionarse con el cuidado y los recursos correspondientes. Desafortunadamente, este nivel de planificación y gestión no se está produciendo”, escribió el instituto en su carta.

GPT-4 es la última versión del chatbot impulsado por inteligencia artificial de OpenAI, que se lanzó el 14 de marzo. Hasta la fecha, ha aprobado algunos de los exámenes de derecho y de secundaria más rigurosos de EE. UU. dentro del percentil 90. Se entiende que es 10 veces más avanzado que la versión original de ChatGPT.

Existe una "carrera fuera de control" entre las empresas de IA para desarrollar una IA más poderosa, que "nadie –ni siquiera sus creadores- puede entender, predecir o controlar de manera confiable", afirmó FOLI.

Entre las principales preocupaciones estaba si las máquinas podrían inundar los canales de información, potencialmente con “propaganda y falsedad” y si las máquinas “automatizarán” todas las oportunidades de empleo.

FOLI llevó estas preocupaciones un paso más allá, sugiriendo que los esfuerzos empresariales de estas empresas de IA pueden conducir a una amenaza existencial:

“¿Deberíamos desarrollar mentes no humanas que eventualmente puedan superarnos en número, ser más astutas, quedar obsoletas y reemplazarnos? ¿Deberíamos arriesgarnos a perder el control de nuestra civilización?

"Esas decisiones no deben delegarse en líderes tecnológicos no electos", añade la carta.

El instituto también estuvo de acuerdo con una declaración reciente del fundador de OpenAI, Sam Altman, que sugiere que puede ser necesaria una revisión independiente antes de entrenar futuros sistemas de IA.

Altman en su publicación de blog del 24 de febrero destacó la necesidad de prepararse para los robots de inteligencia artificial general (AGI) y superinteligencia artificial (ASI).

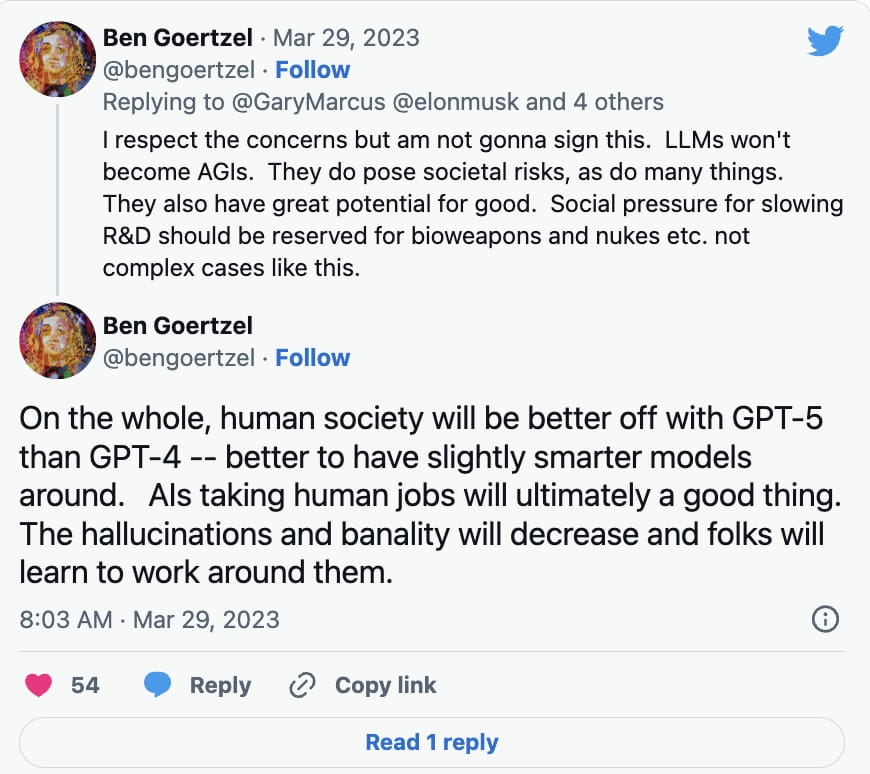

Sin embargo, no todos los expertos en IA se apresuraron a firmar la petición. Ben Goertzel, director ejecutivo de SingularityNET, explicó en una respuesta de Twitter del 29 de marzo a Gary Marcus, autor de Rebooting.AI, que los modelos de aprendizaje de idiomas (LLM) no se convertirán en AGI, de los cuales, hasta la fecha, ha habido pocos desarrollos.

En cambio, dijo que la investigación y el desarrollo de cosas como armas biológicas y nucleares deberían frenarse:

Además de los modelos de aprendizaje de idiomas como ChatGPT, se ha utilizado tecnología deep fake impulsada por IA para crear imágenes, audio y vídeos convincentes. La tecnología también se ha utilizado para crear obras de arte generadas por IA, y se han planteado algunas preocupaciones sobre si podría violar las leyes de derechos de autor en ciertos casos.

El director ejecutivo de Galaxy Digital, Mike Novogratz, dijo recientemente a los inversores que estaba sorprendido por la cantidad de atención regulatoria que se ha prestado a las criptomonedas, mientras que poca se ha centrado en la inteligencia artificial.

“Cuando pienso en la IA, me sorprende que estemos hablando tanto de regulación de las criptomonedas y nada de regulación de la IA. Quiero decir, creo que el gobierno lo tiene completamente patas arriba”, opinó durante una llamada a accionistas el 28 de marzo.

FOLI ha argumentado que si la pausa en el desarrollo de la IA no se promulga rápidamente, los gobiernos deberían involucrarse con una moratoria.

“Esta pausa debería ser pública y verificable, e incluir a todos los actores clave. Si esa pausa no puede implementarse rápidamente, los gobiernos deberían intervenir e instituir una moratoria”, escribió.