(Desde la experiencia del desarrollador y la combinabilidad, el valor a largo plazo de $VANRY )

Si me preguntas: ¿con qué gana la infraestructura AI-first? No hablaré primero de TPS, tampoco de narrativas. Primero haré una pregunta más 'ingenieril': ¿los desarrolladores pueden integrar las capacidades del agente como si fueran bloques de construcción y hacer que funcione de manera estable durante un año?

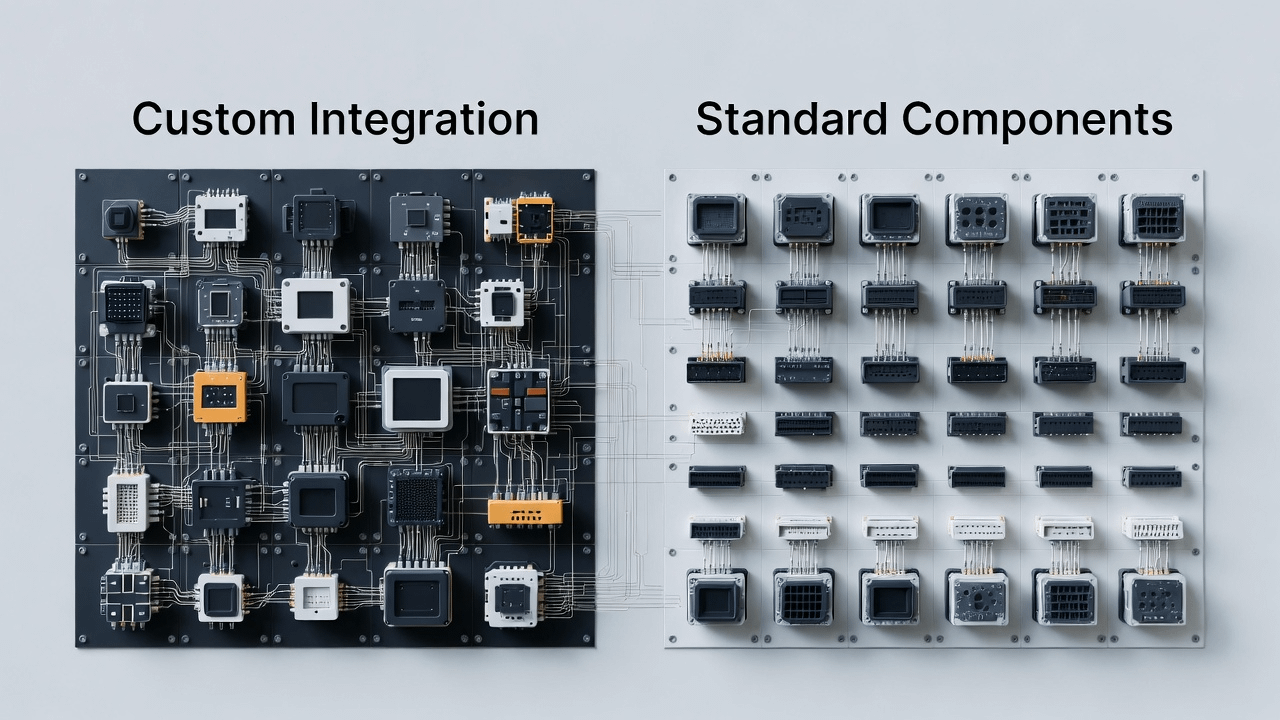

La IA está llevando a Web3 a una nueva fase: en la cadena no solo hay activos y contratos, sino que también aparecerán una gran cantidad de 'módulos inteligentes'. Se asemejan a bibliotecas y servicios en ingeniería de software: algunos se dedican a memoria semántica, otros a inferencia y explicación, otros a ejecución automatizada, otros a liquidación y cumplimiento. El problema es que — si estas capacidades carecen de una manera de acceso unificada y de una abstracción subyacente reutilizable, los desarrolladores se verán atrapados en un 'infierno de integración' interminable:

Cada vez que se incorpora un componente inteligente, se debe volver a adaptar la estructura de datos

Cada vez que se cambia de ecosistema, se debe reescribir un conjunto de capas de integración

Una vez que realmente esté en línea, es muy difícil localizar problemas: ¿se perdió la memoria? ¿Se desvió la inferencia? ¿No se activaron las condiciones de ejecución? ¿O se bloqueó el canal de liquidación?

Al final, el agente se convierte en un montón de demos dispersas, incapaz de escalar.

Esta es mi comprensión de la entrada de Vanar: no se trata de hacer 'IA más inteligente', ni de hacer 'cadenas más rápidas'. Se trata más de hacer algo a largo plazo pero clave: convertir las capacidades centrales que necesita el agente en componentes estándar de infraestructura, permitiendo a los desarrolladores construir aplicaciones inteligentes que puedan estar en línea con menos fricción.

En otras palabras: la competencia en la era de IA, muchas veces se trata de 'quién es más fácil de usar'. Quien pueda bajar el 'costo de acceso', el 'costo de reutilización' y el 'costo inter-ecosistema', será más fácil que se convierta en la opción predeterminada.

1) AI-first vs AI-added: la diferencia no está en la declaración publicitaria, sino en '¿la interfaz estuvo diseñada desde el principio para módulos inteligentes?'

Muchas cadenas dirán 'nosotros también soportamos IA'. Pero cuando observes el flujo de trabajo real de los desarrolladores, conocerás la diferencia:

'AI-added' generalmente considera la IA como una función de capa de aplicación, hace algunos SDK, hace algunas demostraciones, y luego espera que el ecosistema crezca por sí solo. Pero para que los módulos inteligentes se escalen, lo que más temen es que la capa inferior no haya reservado las interfaces y abstracciones correctas para ellos.

El significado de AI-first es más específico en ingeniería:

Desde el primer día, se asume que habrá una gran cantidad de agentes llamando y módulos inteligentes colaborando en la cadena, por lo que se necesita un soporte más nativo: disponibilidad a largo plazo del estado, trazabilidad del proceso de inferencia, automatización controlable de acciones, y un ciclo cerrado que pueda liquidarse. Estas no son funciones que se puedan agregar con un botón, es más como si decidieras desde el principio cómo debería diseñarse el núcleo del sistema operativo.

@Vanarchain de los Puntos de Conversación enfatiza 'alinearse con el uso real y no con la narrativa', yo prefiero traducirlo como un lenguaje de ingeniería:

No preguntes si puedes hacer una demostración, primero pregunta si puedes proporcionar a los desarrolladores una capa base de agente que sea reutilizable y mantenible.

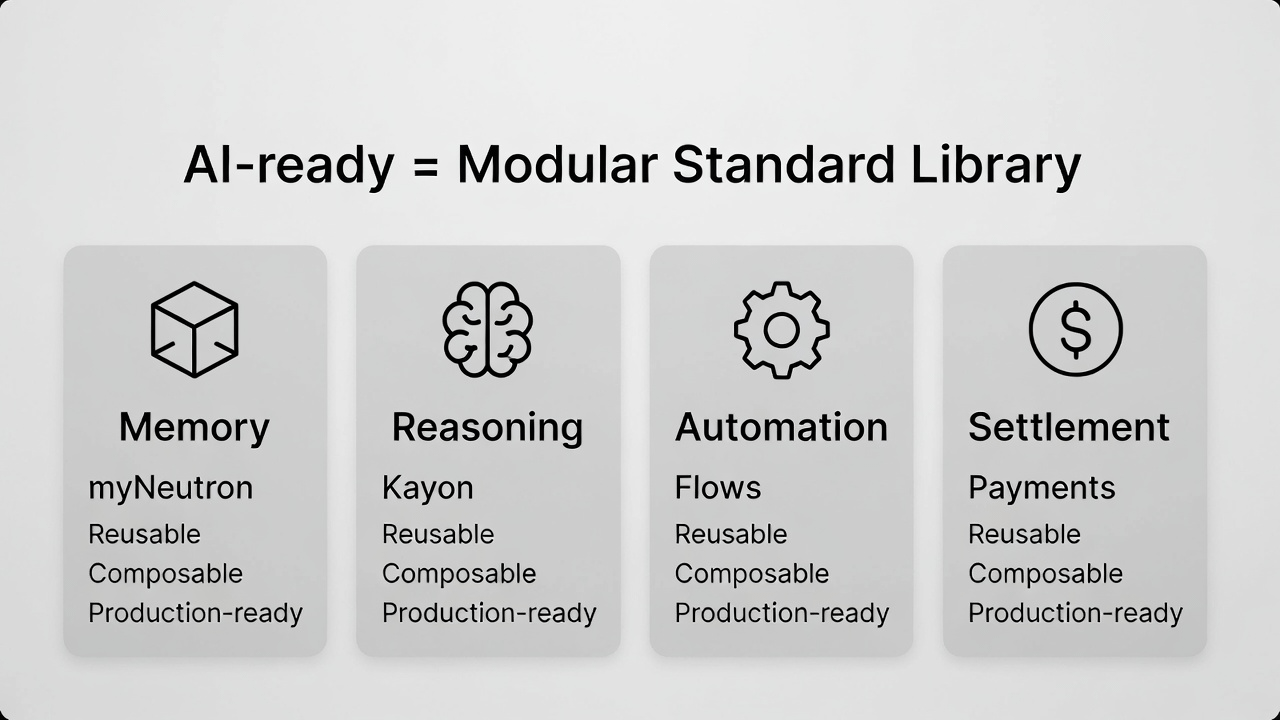

2) ¿Qué significa realmente 'AI-ready'? Desde la perspectiva del desarrollador, son cuatro capacidades básicas que 'deben existir y poder colaborar'.

Mucha gente malinterpreta 'AI-ready' como 'más rápido'. Pero cuando realmente haces aplicaciones de agentes, te das cuenta de que la velocidad es solo la superficie. Más profundo son las cuatro capacidades que deben poder trabajar juntas, de lo contrario, todo el sistema será difícil de salir del POC:

Memoria: no es 'qué se ha hablado', sino el contexto y estado semántico que el agente necesita para tareas a largo plazo.

Razonamiento: no es 'dar respuestas', sino permitir que la cadena de decisiones sea entendida, revisada y confiable.

Automatización: no es 'poder ejecutar', sino poder convertir la ejecución en componentes de proceso estables.

Liquidación: no es 'poder hacer transferencias', sino poder convertir la acción del agente en un ciclo cerrado de actividad económica real.

Hacer estas cuatro cosas no es difícil, lo difícil es hacerlas combinables: ¿los desarrolladores pueden juntarlas como una biblioteca estándar, evitando errores, reescrituras y costos de integración?

@Vanarchain ejemplos de productos (myNeutron / Kayon / Flows) no los consideraría como 'tres funciones específicas', sino más bien como tres componentes básicos:

Alguien es responsable de convertir 'estado semántico' en una capacidad de capa base (correspondiente a myNeutron)

Alguien es responsable de convertir 'inferencias y explicaciones' en capacidades reutilizables (correspondiente a Kayon)

Alguien es responsable de convertir 'inteligente → acción' en una capacidad procesal (correspondiente a Flows)

Y agregar 'pistas de liquidación/pago' para cerrar el ciclo de la aplicación, esa es la explicación completa de 'AI-ready' en términos de ingeniería.

3) ¿Por qué 'el lanzamiento de nuevas L1 es más difícil en la era de IA? Porque los desarrolladores no carecen de cadenas, lo que falta es 'middleware de agente maduro'.

En el pasado, las nuevas cadenas podían atraer a los desarrolladores a probar con 'más rápido y más barato'. En la era de la IA, esta lógica se debilita cada vez más:

Los desarrolladores ya tienen suficientes cadenas para elegir, lo que realmente falta es middleware y componentes estándar que permitan la entrega más rápida, la operación más estable y el mantenimiento más fácil de las aplicaciones inteligentes.

Si eres un equipo que está preparando aplicaciones relacionadas con agentes de IA, lo que más temes no es 'no hay lugar en la cadena para desplegar', lo que temes es:

Tienes que construir tu propio sistema de memoria, hacer que la inferencia sea explicable, escribir tus propias barreras de ejecución, y conectar tu propio canal de liquidación.

Una vez que el negocio comience, el costo de mantenimiento aumentará exponencialmente.

Cuanto más exitoso seas, más fácil será que el sistema colapse debido a la inmadurez de algún módulo.

Así que 'la dificultad de nuevas L1' no significa que el mercado no necesite nuevas cadenas, sino que la infraestructura de una simple nueva cadena ya no es escasa; lo que es escaso son combinaciones de componentes inteligentes que se pueden utilizar directamente en producción. Esto también es lo que falta en los Puntos de Conversación de Vanar: 'falta un producto que demuestre la preparación para la IA' — lo traduzco como: falta algo que ahorre a los desarrolladores medio año de tiempo de integración.

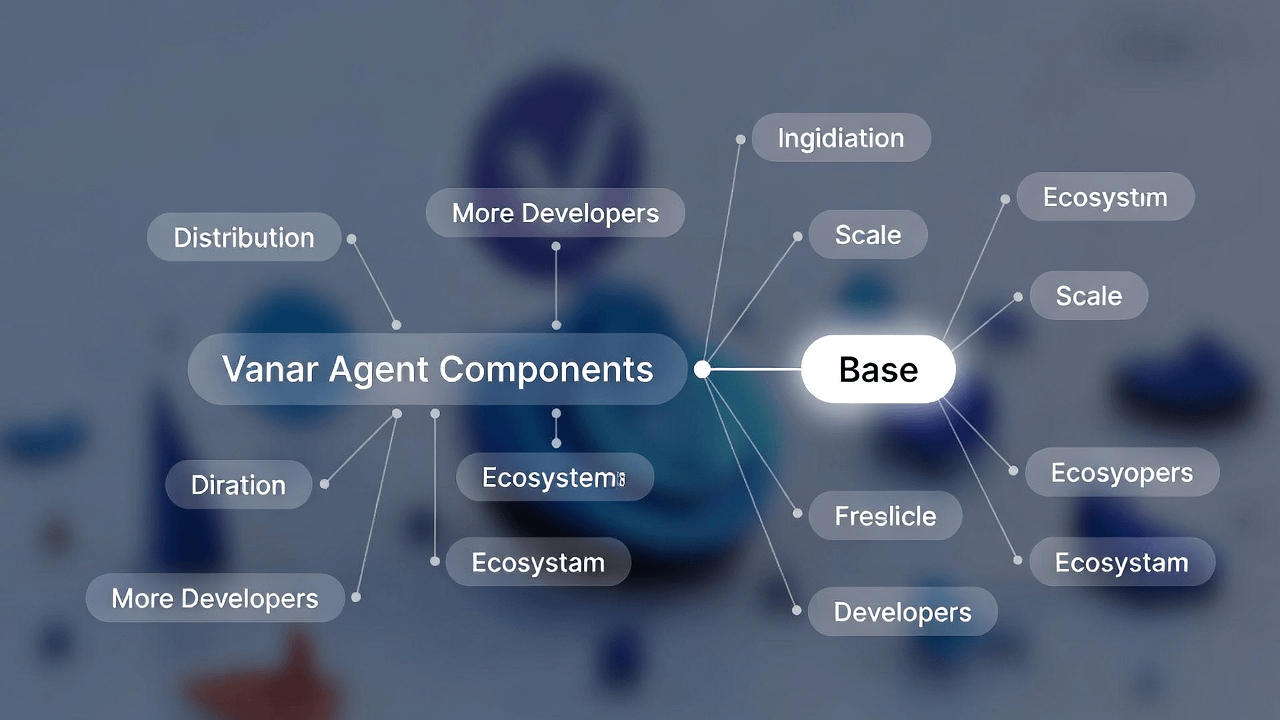

4) La interconexión comienza desde Base: no se trata de 'agregar una implementación', sino de 'hacer que los componentes se distribuyan', llevando la combinabilidad a una mayor densidad de desarrolladores para su validación.

Si realmente estás haciendo 'componentes estándar', naturalmente te preocuparás por la distribución: los componentes solo se iterarán más rápido y se volverán más estables si son utilizados en gran medida, y finalmente se convertirán en la opción predeterminada.

Si la infraestructura AI-first solo circula dentro de una sola red, el uso de los componentes es limitado, la retroalimentación de los desarrolladores es limitada y el ecosistema también puede fácilmente convertirse en un jardín cerrado. Vanar comienza siendo utilizable en múltiples cadenas desde Base, desde esta perspectiva, parece más una opción real:

Colocar componentes en lugares donde los desarrolladores están más concentrados y donde hay más aplicaciones, aumentando la frecuencia de contacto y uso, para que la 'combinabilidad' realmente escale.

Esto también afectará directamente el camino de valor de $VANRY : cuando más ecosistemas puedan invocar el mismo conjunto de componentes inteligentes y capacidades de liquidación, el ámbito de uso se ampliará y el camino de acumulación de valor potencial será más claro.

5) ¿Por qué el pago/liquidación es un curso obligatorio para AI-first? Porque sin un ciclo cerrado, los desarrolladores siempre se quedarán en el nivel de 'útil pero no genera valor'.

Notarás que muchas aplicaciones de IA 'parecen muy útiles', pero a largo plazo no crecen: porque se quedan en la capa de recomendaciones, en la capa de herramientas, y carecen de un ciclo cerrado que desencadene actividades económicas reales. Esto es aún más cierto para Web3: el agente ha tomado una decisión, pero si no puede entrar sin problemas en la pista de liquidación, solo puede hacer 'sugerencias', y es difícil convertirse en 'acción'.

Los Puntos de Conversación de Vanar enfatizan que 'los agentes no utilizan la UX de billeteras', esta frase es realmente clave:

Lo que el agente necesita es un canal de liquidación orquestable, no que actúe como un humano presionando botones. Solo cuando la pista de liquidación exista de manera estable, los desarrolladores estarán dispuestos a aplicar el agente en formas orientadas a empresas o negocios reales.

Conectando este punto de vista de 'combinabilidad': la capacidad de liquidación no es un módulo adicional, sino la última pieza del rompecabezas que debe existir en la biblioteca estándar. De lo contrario, el sistema que construyas siempre le faltará una 'salida para completar la tarea'.

6) $VANRY: más como 'acumulación de valor por el uso de desarrolladores y la invocación de componentes', en lugar de impulsado por emociones a corto plazo

Si estás de acuerdo con la ruta de 'componentes estándar + distribución', entonces $VANRY es más fácil de entender con la lógica de infraestructura:

No se trata de apostar por una moda a corto plazo, sino de apostar por la demanda de uso a largo plazo que surge después de que esta capa base de agente sea adoptada por más aplicaciones y llamada por más ecosistemas.

Esta también es la última línea de los Puntos de Conversación: 'listo, no narrativas'. Dicho de manera más directa:

Cuando el producto realmente se utiliza, el valor se acumula de una manera muy simple; y cuando el valor depende de la narrativa, el crecimiento suele ser más frágil.

En la era de la IA, esta diferencia será más evidente. Porque las empresas, instituciones y equipos que realmente desarrollan aplicaciones serán cada vez más sensibles a la 'entregabilidad'. Quien pueda reducir el costo de entrega de las aplicaciones de agentes, será más probable que se convierta en la próxima opción de infraestructura.

Conclusión: los ganadores de la era de IA suelen ser quienes 'simplifican capacidades complejas'.

Al mirar la información central de @Vanarchain , notarás que no se apresuran a empaquetarse como 'la cadena de IA que mejor cuenta historias'. Más bien, se parecen a la capa que 'es fácil de usar para los desarrolladores': convertir capacidades complejas como memoria, inferencia, automatización y liquidación en componentes combinables, y luego expandir el ámbito de uso a través de la distribución entre cadenas.

Este camino no necesariamente es el más ruidoso, pero si los agentes de IA realmente se convierten en una forma importante de usuario en Web3, el valor de la infraestructura provendrá más de 'ser adoptada de manera continua'. Y a largo plazo, simplificar capacidades complejas a menudo tiene más valor que 'hacer que el concepto suene más grande'.