Mehr als 2.600 Technologieführer und Forscher haben einen offenen Brief unterzeichnet, in dem sie zu einer vorübergehenden „Pause“ bei der weiteren Entwicklung künstlicher Intelligenz (KI) aufrufen, da sie „erhebliche Risiken für die Gesellschaft und die Menschheit“ befürchten.

Zu den Unterzeichnern des Briefes, der am 22. März von der US-amerikanischen Denkfabrik Future of Life Institute (FOLI) verfasst wurde, gehörten Tesla-Chef Elon Musk, Apple-Mitbegründer Steve Wozniak sowie eine Reihe von KI-CEOs, CTOs und Forschern.

Das Institut forderte alle KI-Unternehmen auf, das Training von KI-Systemen, die leistungsfähiger als GPT-4 sind, für mindestens sechs Monate „sofort zu pausieren“ und äußerte unter anderem seine Bedenken, dass „die mit dem Menschen konkurrierende Intelligenz tiefgreifende Risiken für die Gesellschaft und die Menschheit bergen kann“:

„Fortschrittliche KI könnte einen tiefgreifenden Wandel in der Geschichte des Lebens auf der Erde bedeuten und sollte mit der entsprechenden Sorgfalt und den entsprechenden Ressourcen geplant und verwaltet werden. Leider findet dieses Maß an Planung und Verwaltung nicht statt“, schrieb das Institut in seinem Brief.

GPT-4 ist die neueste Version des auf künstlicher Intelligenz basierenden Chatbots von OpenAI, der am 14. März veröffentlicht wurde. Bis heute hat er einige der anspruchsvollsten US-Highschool- und Jura-Prüfungen innerhalb des 90. Perzentils bestanden. Er ist schätzungsweise zehnmal fortschrittlicher als die ursprüngliche Version von ChatGPT.

Es gebe ein „außer Kontrolle geratenes Rennen“ zwischen KI-Unternehmen um die Entwicklung leistungsfähigerer KI, die „niemand – nicht einmal ihre Entwickler – verstehen, vorhersagen oder zuverlässig kontrollieren kann“, so FOLI.

Zu den größten Sorgen zählten, dass Maschinen die Informationskanäle möglicherweise mit „Propaganda und Unwahrheiten“ überfluten könnten und dass Maschinen durch Automatisierung sämtliche Beschäftigungsmöglichkeiten „wegautomatisieren“ würden.

FOLI ging mit diesen Bedenken noch einen Schritt weiter und wies darauf hin, dass die unternehmerischen Bemühungen dieser KI-Unternehmen zu einer existenziellen Bedrohung führen könnten:

„Sollten wir nichtmenschliche Gehirne entwickeln, die uns irgendwann zahlenmäßig überlegen, überlisten, überflüssig machen und ersetzen könnten? Sollten wir riskieren, die Kontrolle über unsere Zivilisation zu verlieren?“

„Solche Entscheidungen dürfen nicht an nicht gewählte Technologieführer delegiert werden“, heißt es in dem Brief weiter.

Das Institut stimmte außerdem einer kürzlichen Aussage des OpenAI-Gründers Sam Altman zu, wonach vor der Schulung künftiger KI-Systeme möglicherweise eine unabhängige Überprüfung erforderlich sei.

Altman betonte in seinem Blogbeitrag vom 24. Februar die Notwendigkeit, sich auf Roboter mit künstlicher allgemeiner Intelligenz (AGI) und künstlicher Superintelligenz (ASI) vorzubereiten.

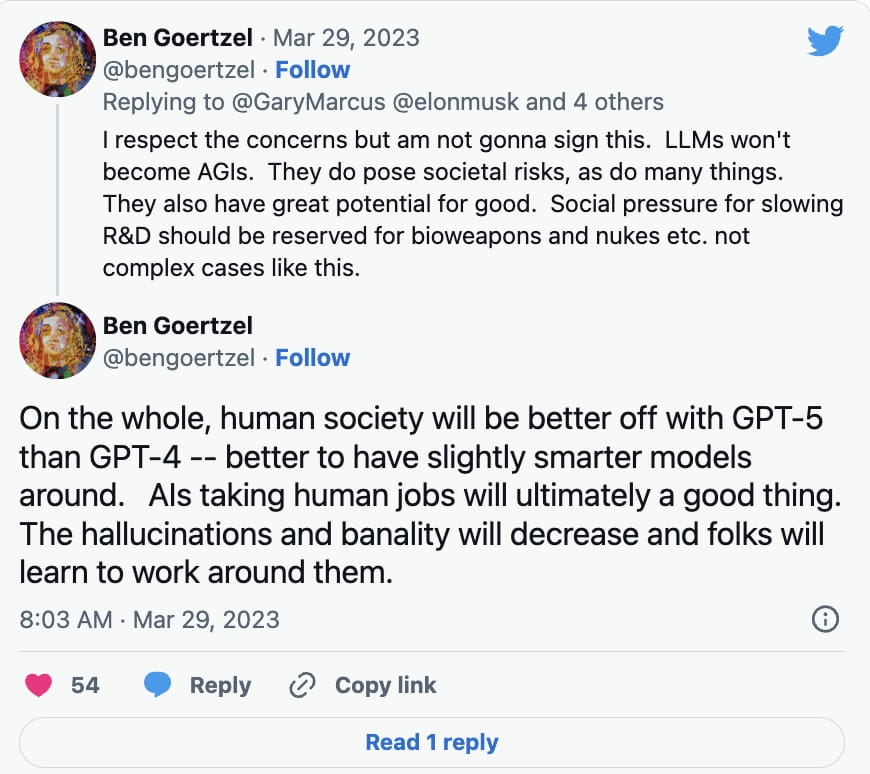

Allerdings haben nicht alle KI-Experten die Petition sofort unterzeichnet. Ben Goertzel, CEO von SingularityNET, erklärte in einer Twitter-Antwort vom 29. März an Gary Marcus, den Autor von Rebooting.AI, dass aus Sprachlernmodellen (LLMs) keine AGIs werden, zu denen es bislang nur wenige Entwicklungen gegeben habe.

Stattdessen müsse die Forschung und Entwicklung im Bereich von Biowaffen und Atomwaffen gedrosselt werden, forderte er:

Neben Sprachlernmodellen wie ChatGPT wurde KI-gestützte Deep-Fake-Technologie verwendet, um überzeugende Bilder, Audio- und Video-Hoaxes zu erstellen. Die Technologie wurde auch verwendet, um KI-generierte Kunstwerke zu erstellen, wobei einige Bedenken geäußert wurden, ob sie in bestimmten Fällen gegen Urheberrechte verstoßen könnte.

Mike Novogratz, CEO von Galaxy Digital, sagte Investoren kürzlich, er sei schockiert über die große regulatorische Aufmerksamkeit, die den Kryptowährungen gewidmet werde, während der künstlichen Intelligenz nur wenig Beachtung geschenkt werde.

„Wenn ich an KI denke, schockiert es mich, dass wir so viel über Krypto-Regulierung und nichts über KI-Regulierung reden. Ich meine, ich glaube, die Regierung hat das völlig auf den Kopf gestellt“, meinte er während einer Aktionärskonferenz am 28. März.

FOLI argumentiert, dass die Regierungen ein Moratorium einführen sollten, falls es nicht rasch zu einer Unterbrechung der KI-Entwicklung kommt.

„Diese Pause sollte öffentlich und überprüfbar sein und alle wichtigen Akteure einschließen. Wenn eine solche Pause nicht schnell durchgesetzt werden kann, sollten die Regierungen eingreifen und ein Moratorium verhängen“, heißt es in dem Bericht.