(Aus der Perspektive der Entwicklererfahrung und Kombinierbarkeit der langfristigen Werte von $VANRY )

Wenn du mich fragst: Worauf basiert der Gewinn der AI-first-Infrastruktur? Ich werde nicht zuerst über TPS sprechen, noch werde ich zuerst über Erzählungen sprechen. Ich werde zuerst eine viel 'ingenieurtechnischere' Frage stellen: Können Entwickler die Fähigkeiten des Agenten wie Bausteine zusammenfügen und stabil ein Jahr lang betreiben?

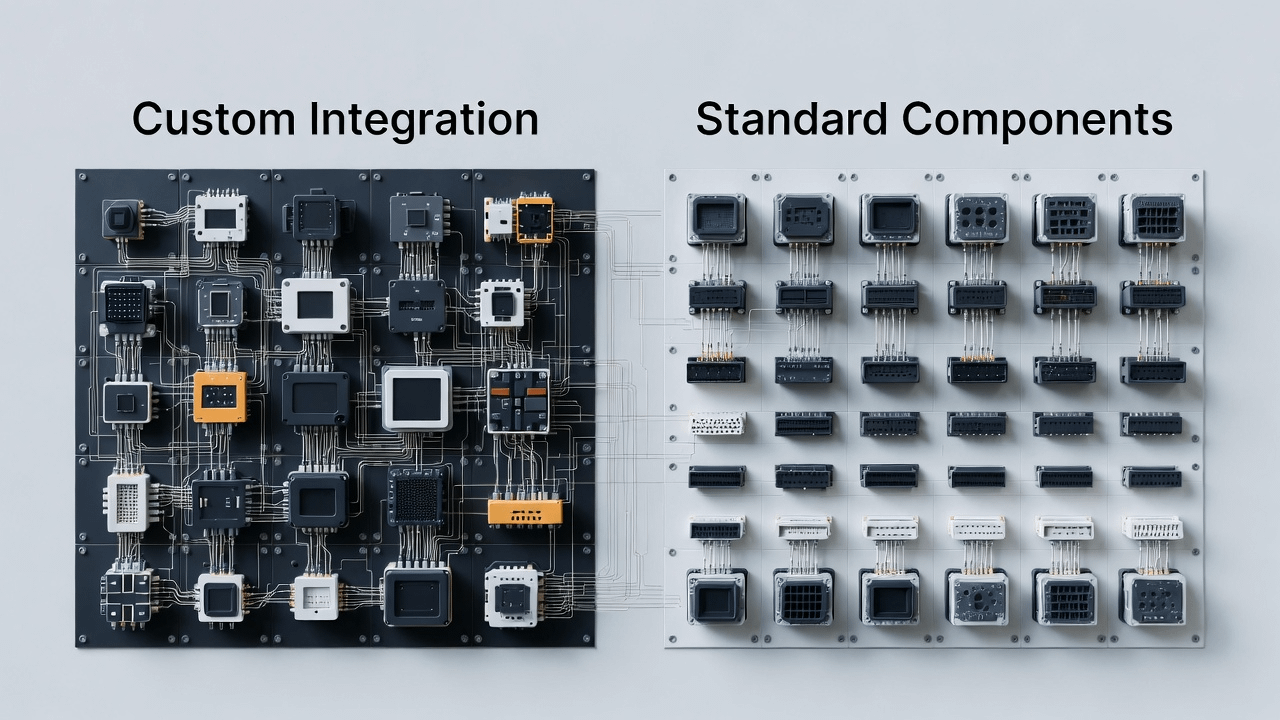

AI bringt Web3 in eine neue Phase: Auf der Kette gibt es nicht nur Vermögenswerte und Verträge, sondern auch eine Vielzahl von 'intelligenten Modulen'. Sie sind ähnlich wie Bibliotheken und Dienste in der Softwaretechnik: Manche sind speziell für semantisches Gedächtnis, andere für Schlussfolgerungserklärungen, andere für automatisierte Ausführung, andere für Abrechnung und Compliance. Das Problem ist - wenn diese Fähigkeiten keinen einheitlichen Zugang und keine wiederverwendbaren abstrakten Grundlagen haben, werden Entwickler in eine endlose 'Integrationshölle' geraten:

Jeder intelligente Komponente muss die Datenstruktur neu angepasst werden.

Jedes Mal, wenn ein Ökosystem gewechselt wird, muss eine neue Integrationsschicht geschrieben werden.

Nachdem es wirklich online ist, ist es sehr schwer, Probleme zu lokalisieren: Ist das Gedächtnis verloren gegangen? Ist die Schlussfolgerung fehlerhaft? Haben die Ausführungsbedingungen nicht funktioniert? Oder ist der Abrechnungsweg blockiert?

Am Ende wird der Agent zu einer Ansammlung von fragmentierten Demos, die nicht in großem Maßstab umgesetzt werden können.

Das ist, was ich als den Zugang von Vanar verstehe: Es geht nicht darum, 'intelligentere AI' zu machen, und es geht nicht darum, 'schnellere Ketten' zu machen. Es ist vielmehr eine langfristige, aber entscheidende Angelegenheit: die Kernfähigkeiten, die der Agent benötigt, in Standardkomponenten der Infrastrukturebene zu verankern, damit Entwickler mit weniger Reibung einsatzbereite intelligente Anwendungen erstellen können.

Anders ausgedrückt: Der Wettbewerb im AI-Zeitalter ist oft 'wer besser zu benutzen ist'. Wer die 'Anschlusskosten' senken kann, die 'Wiederverwendungskosten' senken kann und die 'plattformeigenen Kosten' senken kann, der wird eher zur Standardwahl.

1) AI-first vs AI-added: Der Unterschied liegt nicht in der Werbung, sondern darin, ob die Schnittstelle von Anfang an für intelligente Module entworfen ist.

Viele Ketten sagen: 'Wir unterstützen auch AI'. Aber wenn du die tatsächlichen Arbeitsabläufe der Entwickler ansiehst, wirst du den Unterschied erkennen:

'AI-added' ist normalerweise, AI als Funktion auf Anwendungsebene zu betrachten, einige SDKs oder Demos zu erstellen und dann zu hoffen, dass das Ökosystem von selbst wächst. Aber um intelligentes Modul zu skalieren, ist das Schlimmste: Die Basis hat keine richtigen Schnittstellen und Abstraktionen reserviert.

Die Bedeutung von AI-first ist in der Technik konkreter:

Von Tag eins an wird angenommen, dass es viele intelligente Agenten gibt, die zusammenarbeiten, und daher muss es natürlicher unterstützt werden: langfristige Verfügbarkeit des Status, Rückverfolgbarkeit des Schlussfolgerungsprozesses, kontrollierte Automatisierung der Aktionen und ein abgerechneter geschlossener Kreis. Diese Dinge sind nicht nur durch das Hinzufügen eines Funktionsknopfs zu kompensieren; es ist mehr so, als ob du von Anfang an entscheidest, wie das Betriebssystem des Kerns gestaltet werden soll.

@Vanarchain 's Talking Points betonen 'die Ausrichtung an der realen Nutzung und nicht an Erzählungen', ich würde es lieber in eine ingenieurtechnische Sprache übersetzen:

Frag nicht, ob du eine Demo machen kannst, frag zuerst, ob du den Entwicklern eine wiederverwendbare, wartbare Basis für den Agenten geben kannst.

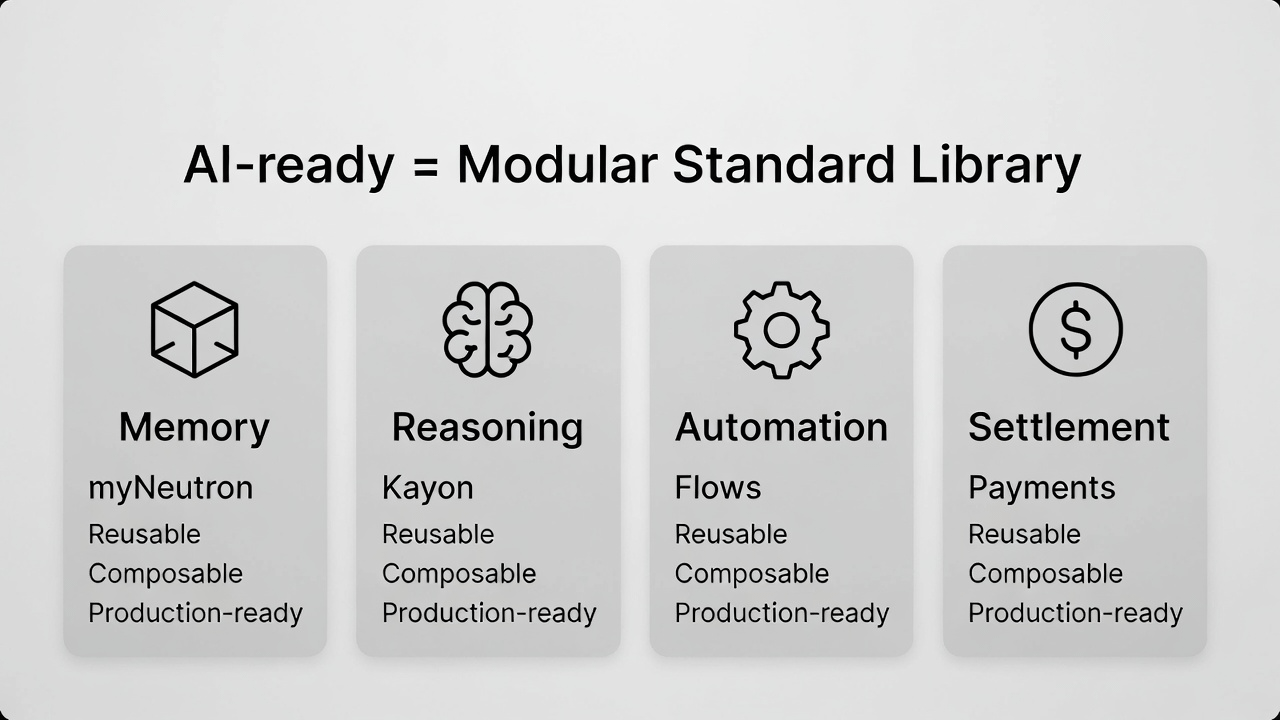

2) Was ist 'AI-ready' eigentlich? Aus der Perspektive der Entwickler sind es vier 'grundlegende Fähigkeiten, die vorhanden sein und zusammenarbeiten müssen'.

Viele Menschen missverstehen AI-ready als 'schneller'. Aber wenn du tatsächlich intelligente Agentenanwendungen machst, wirst du feststellen, dass Geschwindigkeit nur die Oberfläche ist. Tiefer ist es wichtig, dass die vier Fähigkeiten zusammenarbeiten können, sonst wird das gesamte System schwer aus dem POC herauskommen:

Memory (Gedächtnis): Es geht nicht darum, 'was besprochen wurde', sondern um den Kontext und den semantischen Zustand, den der Agent für langfristige Aufgaben benötigt.

Reasoning (Schlussfolgerung): Es geht nicht darum, 'Antworten zu geben', sondern darum, dass die Entscheidungskette verstanden, überprüft und vertraut wird.

Automation (Automatisierung): Es geht nicht darum, 'auszuführen', sondern darum, das Ausführen in stabile Prozesskomponenten zu verwandeln.

Settlement (Abrechnung): Es geht nicht darum, 'Überweisungen zu machen', sondern darum, die Aktionen des Agenten in einen geschlossenen Kreis echter wirtschaftlicher Aktivitäten umzuwandeln.

Es ist nicht schwer, diese vier Dinge zusammenzubringen, aber es ist schwierig, sie kombinierbar zu machen: Können Entwickler sie wie eine Standardbibliothek zusammenfügen, weniger Fallstricke haben, weniger neu schreiben und geringere Integrationskosten haben.

@Vanarchain Produktbeispiele (myNeutron / Kayon / Flows) werde ich nicht als 'drei Funktionen' betrachten, sondern eher als drei grundlegende Komponenten:

Es gibt jemanden, der dafür verantwortlich ist, 'semantische Zustände' in grundlegende Fähigkeiten umzuwandeln (entspricht myNeutron).

Es gibt jemanden, der dafür verantwortlich ist, 'Schlussfolgerung und Erklärung' in eine wiederverwendbare Fähigkeit umzuwandeln (entspricht Kayon).

Es gibt jemanden, der dafür verantwortlich ist, 'Intelligenz → Aktion' in einen prozessualen Ansatz umzuwandeln (entspricht Flows).

Zusätzlich dazu, dass 'Abrechnungs-/Zahlungsstrecken' die Anwendung schließt, ist das die vollständige Erklärung von 'AI-ready' in der Technik.

3) Warum ist die 'Veröffentlichung von neuen L1' im AI-Zeitalter schwieriger? Weil Entwickler nicht an Ketten mangeln, sondern an 'reifer Middleware für Agenten'.

Früher konnte die neue Kette Entwickler mit 'schneller und günstiger' anziehen. Im AI-Zeitalter wird diese Logik immer schwächer:

Entwickler hatten schon genug Ketten zur Auswahl, was wirklich fehlt, sind Middleware und Standardkomponenten, die intelligente Anwendungen schneller bereitstellen, stabiler laufen und einfacher zu warten sind.

Wenn du ein Team bist, das plant, Anwendungen im Zusammenhang mit AI-Agenten zu entwickeln, ist das Schlimmste für dich nicht 'kein Platz für die Bereitstellung in der Kette', sondern:

Du musst selbst ein Gedächtnissystem aufbauen, selbst Schlussfolgerungen erklärbar machen, selbst Ausführungsgrenzen schreiben und selbst Abrechnungswege integrieren.

Sobald das Geschäft läuft, steigen die Wartungskosten exponentiell.

Je erfolgreicher du bist, desto eher kann das System aufgrund eines unreifen Moduls zusammenbrechen.

Daher ist die Schwierigkeit bei 'neuen L1' nicht, dass der Markt keine neuen Ketten braucht, sondern dass die Infrastruktur einer neuen Kette nicht mehr selten ist; was rar ist, sind Kombinationen intelligenter Komponenten, die direkt in der Produktion verwendet werden können. Das ist auch der Punkt in den Vanar Talking Points, dass 'was fehlt, sind Produkte, die die AI-readiness beweisen' – ich übersetze das als: was fehlt, sind Dinge, die den Entwicklern ein halbes Jahr Integrationszeit sparen.

4) Plattformübergreifend beginnen mit Base: Es geht nicht darum, 'eine weitere Bereitstellung hinzuzufügen', sondern darum, 'Komponenten zur Verteilung zu bringen' und die Kombinierbarkeit in eine größere Dichte von Entwicklern zu validieren.

Wenn du wirklich 'Standardkomponenten' machst, wirst du natürlich an der Verteilung interessiert sein: Komponenten werden nur dann schneller iterieren, stabiler werden und schließlich zur Standardoption werden, wenn sie weit verbreitet verwendet werden.

Wenn die AI-first-Infrastruktur nur innerhalb eines einzelnen Netzwerks zirkuliert, ist der Nutzungshorizont der Komponenten begrenzt, das Feedback der Entwickler ist begrenzt, und das Ökosystem kann leicht zu einem geschlossenen Garten werden. Vanar begann mit Base, um plattformübergreifend verfügbar zu sein, aus dieser Perspektive sieht es mehr nach einer realistischen Wahl aus:

Setzen Sie die Komponenten an Orten ein, die für Entwickler dichter und Anwendungen zahlreicher sind, um die Erreichbarkeit und Nutzungsfrequenz zu erhöhen, damit die 'Kombinierbarkeit' wirklich in großem Maßstab funktioniert.

Das wird auch den Wertweg von $VANRY direkt beeinflussen: Wenn mehr Ökosysteme dieselben intelligenten Komponenten und Abrechnungsfähigkeiten nutzen können, wird der Nutzungshorizont erweitert und der potenzielle Wertakkumulationsweg wird auch klarer.

5) Warum sind Zahlungen/Abrechnungen ein Muss für AI-first? Weil ohne geschlossenen Kreis die Entwickler immer auf 'nützlich, aber keinen Wert erzeugend' stehen bleiben.

Du wirst feststellen, dass viele AI-Anwendungen 'sehr nützlich aussehen', aber langfristig nicht groß werden: weil sie auf der Ebene der Empfehlungen und Werkzeuge stehen, ohne einen geschlossenen Kreis, der echte wirtschaftliche Aktivitäten auslösen kann. Das gilt umso mehr für Web3 - der Agent hat eine Entscheidung getroffen; wenn er nicht reibungslos in die Abrechnungsstrecke übergehen kann, kann er nur 'Hinweise' geben und es ist schwierig, 'Aktionen' zu werden.

Vanar Talking Points betonen, dass 'Agenten keine Wallet-UX verwenden', dieser Satz ist tatsächlich sehr entscheidend:

Was der Agent braucht, ist ein orchestrierbarer Abrechnungsweg, nicht etwas, das wie ein Mensch Knöpfe drückt. Nur wenn die Abrechnungsstrecke stabil vorhanden ist, sind Entwickler bereit, die Anwendung des Agenten in eine Form zu bringen, die auf Unternehmen oder echte Geschäfte ausgerichtet ist.

Bringe diesen Punkt in die Perspektive der 'Kombinierbarkeit' zurück: Abrechnungsfähigkeiten sind kein zusätzliches Modul, sondern das letzte Puzzlestück, das in der Standardbibliothek vorhanden sein muss. Andernfalls wird das System, das du zusammenstellst, für immer einen 'Ausgang für die Erledigung von Aufgaben' vermissen.

6) $VANRY: mehr wie 'Wertakkumulation durch die Verwendung von Entwicklern und Komponentenaufrufen', statt von Emotionen angetriebenen kurzfristigen Tickets.

Wenn du die Route 'Standardkomponenten + Verteilung' akzeptierst, dann ist $VANRY einfacher mit Infrastrukturlogik zu verstehen:

Es geht nicht darum, auf einen kurzfristigen Hype zu setzen, sondern auf die langfristige Nachfrage nach dieser intelligenten Agenten-Basisschicht, die von mehr Anwendungen und mehr Ökosystemen angenommen wird.

Das ist auch der letzte Punkt von Talking Points: 'readiness not narratives'. Einfacher ausgedrückt:

Wenn das Produkt wirklich genutzt wird, wird der Wert auf sehr einfache Weise akkumuliert; und wenn der Wert von Erzählungen abhängt, ist das Wachstum oft fragil.

Im AI-Zeitalter wird dieser Unterschied offensichtlicher. Denn Unternehmen, Institutionen und Teams, die ernsthaft Anwendungen entwickeln, werden immer sensibler für die 'Lieferfähigkeit' sein. Wer die Kosten für die Bereitstellung von intelligenten Anwendungen senken kann, wird wahrscheinlicher die nächste Welle der Infrastrukturwahl.

Fazit: Die Gewinner im AI-Zeitalter sind oft die, die 'komplexe Fähigkeiten einfach machen'.

Wenn du die Kerninformationen von @Vanarchain betrachtest, wirst du feststellen, dass es nicht eilig ist, sich als 'die KI-Kette, die die besten Geschichten erzählt' zu verpacken. Es macht eher das, was für Entwickler am einfachsten zu verwenden ist: Es verwandelt Gedächtnis, Schlussfolgerung, Automatisierung und Abrechnung in kombinierbare Komponenten und erweitert dann die Nutzung durch plattformübergreifende Verteilung.

Dieser Weg muss nicht der lauteste sein, aber wenn AI-Agenten wirklich eine wichtige Benutzerform im Web3 werden, wird der Wert der Infrastruktur mehr von 'fortlaufender Annahme' abhängen. Langfristig ist es oft wertvoller, komplexe Fähigkeiten zu vereinfachen, als 'die Konzepte größer zu machen'.